算法导论 读书笔记¶

第一部分:基础知识¶

第1章:算法在计算中的作用¶

- 算法 即是一系列的计算步骤,用来将一个有效的输入转换成一个有效的输出。

- 计算机的有限的资源必须被有效的利用,算法就是来解决这些问题的方法。

第2章:算法入门¶

- 循环不变式 的三个性质:(循环不变式通常用来证明递归的正确性)

- 初始化:它在循环的第一轮迭代开始之前,应该是正确的。

- 保持:如果在循环的某一次迭代开始之前它是正确的,那么,在下一次迭代开始之前,它也应该保持正确。

- 终止:当循环结束时,不变式给了我们一个有用的性质,它有助于表明算法是正确的。

- 伪代码中的约定:

- 书写上的”缩进”表示程序中的分程序(程序块)结构。

- while,for,repeat等循环结构和if,then,else条件结构与Pascal中相同。

- 符号 “▷”表示后面部分是个注释。

- 多重赋值i←j←e是将表达式e的值赋给变量i和j;等价于j←e,再进行赋值i←j。

- 变量(如i,j和key等)是局部给定过程的。

- 数组元素是通过”数组名[下标]”这样的形式来访问的。

- 复合数据一般组织成对象,它们是由属性(attribute)和域(field)所组成的。

- 参数采用按值传递方式:被调用的过程会收到参数的一份副本。

- 布尔运算符”and”和”or”都是具有短路能力。

- 算法分析即指对一个算法所需要的资源进行预测。

- 对于一个算法,一般只考察其最坏情况的运行时间,理由有三:

- 一个算法的最坏情况运行时间是在任何输入下运行时间的一个上界。

- 对于某些算法来说,最坏情况出现得还是相当频繁的。

- 大致上看来,”平均情况”通常和最坏情况一样差。

- 分治策略 :将原问题划分成n个规模较小而结构与原问题相似的子问题;递归地解决这些小问题,然后再合并其结果,就得到原问题的解。

- 分治模式在每一层递归上都有三个步骤:

- 分解(Divde):将原问题分解成一系列子问题;

- 解决(Conquer):递归地解答各子问题。若子问题足够小,则直接求解;

- 合并(Combine):将子问题的结果合并成原问题的解。

第3章:函数的增长¶

对几个记号的大意:o(非渐近紧确上界) ≈ <; O(渐近上界) ≈ ≤; Θ(渐近紧界)≈ =; Ω(渐近下界)≈ ≥; ω(非渐近紧确下界)≈ >; 这里的<,≤,=,≥,>指的是规模上的比较,即o(g(n))的规模比g(n)小。

o(g(n))={ f(n): 对任意正常数c,存在常数n0>0,使对所有的n≧n0,有0≦f(n)<cg(n) }O(g(n))={ f(n): 存在正常数c和n0,使对所有n≧n0,有0≦f(n)≦cg(n) }Θ(g(n))={ f(n):存在正常数c1,c2和n0,使对所有的n≧n0,有0≦c1g(n)≦f(n)≦c2g(n) }Ω(g(n))={ f(n):存在正常数c和n0,使对所有n≧n0,有0≦cg(n)≦f(n) }ω(g(n))={ f(n) 对任意正常数c,存在常数n0>0,使对所有的n≧n0,有0≦cg(n)<f(n) }

第4章:递归式¶

递归式 是一组等式或不等式,它所描述的函数是用在更小的输入下该函数的值来定义的。 例如Merge-Sort的最坏情况运行时间T(n)可以用以下递归式来表示:

T(n) =2T(n/2) + n, if n > 11, if n=1

解递归式的方法主要有三种:代换法、递归树方法、主方法。

- 代换法(Substitution method)(P38~P40)

- 定义:先猜测某个界的存在,再用数学归纳法去证明该猜测的正确性。缺点:只能用于解的形式很容易猜的情形。总结:这种方法需要经验的积累,可以通过转换为先前见过的类似递归式来求解。

- 递归树方法(Recursion-tree method)

- 起因:代换法有时很难得到一个正确的好的猜测值。用途:画出一个递归树是一种得到好猜测的直接方法。分析(重点):在递归树中,每一个结点都代表递归函数调用集合中一个子问题的代价。将递归树中每一层内的代价相加得到一个每层代价的集合,再将每层的代价相加得到递归式所有层次的总代价。总结:递归树最适合用来产生好的猜测,然后用代换法加以验证。

递归树的方法非常直观,总的代价就是把所有层次的代价相加起来得到。但是分析这个总代价的规模却不是件很容易的事情,有时需要用到很多数学的知识。

- 主方法(Master method)

主方法是最好用的Cookbook方法,太神奇了,可以瞬间估计出递归算法的时间复杂度 ,主方法总结了常见的情况并给出了一个公式。

优点:针对形如T(n)=aT(n’)+f(n)的递归式缺点:并不能解所有形如上式的递归式的解。因为主方法在第1种情况与第2种情况之间、第2种情况与第3种情况之间都存在着一条沟,所以会存在着不能适用的情况。直觉上:实际上主方法一直在比较f(n)与 nlogba 的规模,然后选取规模大的作为最后的递归式的规模。主方法:设a>=1和b>=1是常数f(n)是定义在非负整数上的一个确定的非负函数。又设T(n)也是定义在非负整数上的一个非负函数,且满足递归方程Tn=aTnb+f(n) 方程Tn=aTnb+f(n)中的n/b可以是[n/b],也可以是n/b。那么,在f(n)的三类情况下,我们有T(n)的渐近估计式:

- 若对于某常数ε>0,有 \(f(n)=O(n^{log_b{a-ε}})\) ,则 \(T(n)=Θ(n^{log_b{a}})\) ;

- 若 \(f(n)=Θ(n^{log_b{a}})\) ,则 \(T(n)=Θ(n^{log_b{a}} * logn)\) ;

- 若对其常数ε>0,有 \(f(n)=Ω(n^{log_b{a+ε}})\) 且对于某常数c>1和所有充分大的正整数n有af(n/b)≤cf(n),则 \(T(n)=θ(f(n))\) 。

第5章:概率分析与随机算法¶

随机算法:如果一个算法的行为不只是由输入决定,同时也由随机数生成器所产生的数值决定,则称这个算法是随机的。

指示器随机变量I(A)的定义很简单

\[\begin{split}I(A) = \begin{cases} 0, & 如果A不发生的话 \\ 1, & 如果A发生的话 \end{cases}\end{split}\]

事件A对应的指示器随机变量的期望期等于事件A发生的概率。

介绍了两种 随机排列数组 的生成方法:

随机优先级法:为数组的每个元素赋一个随机的优先级,再根据这个优先级对数组中的元素进行排序。可证这样得到的数字满足随机的性质。

原地交换法:依次把A[i]与A[Random(i+1, Length(A))]进行swap,得到的新数组也满足随机性:

for i ← 1 to n do swap A[i] ↔ A[Random(i, Length(A))]

在真正的环境中的输入可能并不是随机的,所以我们可以采用先将输入进行随机打乱的方法来保证输入数据的随机性,这点在很多算法中得以体现,比如快排有其随机选取种子数来向输入中加入随机化的成分。

生日悖论似乎是很不符合逻辑,但是经过概率分析之后的确如此。

生日悖论非常有意思,理解它的关键在于明白, 在一个23个人的房间内,某2个人生日相同的组合其实有非常多种 的(23*222=253种),所以有2人生日相同的概率接近50%;

- 如果问题变成:你进入一个22个人的房间,发现里面有人和你生日相同的概率是多少时?,这个概率就非常的低了:

f=1-(364/365)^22=0.0585713252643433458470990293331

- 正确的解法应该是考虑k个人的房间中所有人生日都不相同的概率为:

f = 1 - (365/365 * 364/365 * … * (365-n+1)/365) = 0.4756953076625503

- 生日悖论也可以这样进行分解:

1号进入22人房间里有人和他生日相同的概率+2号进入21人房间里有人和他生日相同的概率+3号进入20人房间里有人和他生日相同的概率+…+22号进入1人房间里有人和他生日相同的概率+23号进入0人房间里有人和他生日相同的概率。

对生日悖论正确理解的关键就是在于明白23个人房间里相同生日的组合非常多,明白了这个组合之后就可以进行正确的分解而不是依赖于直觉进行错误的分解。

- 还值得提一下的是”在线雇佣问题”与”苏格拉底的择偶观”很相似。

先用三分之一的时间,即分出大、中、小三类,再用三分之一的时间验证自己的观点是否正确,等到最后三分之一时,选择了属于大类中的一支美丽的麦穗。

第二部分:排序和顺序统计学¶

- 这一部分将要给出几个解决以下排序问题的算法:

- 输入:n个数的序列<a1,a2, … an>

- 输出:输入序列的一个重排<a1’,a2’,…,an’>,使a1’≦a2’≦…≦an’

- 原地排序算法:只有线性个数的元素会被移动到集合之外的排序算法。

- 第6章介绍堆排序

- 第7章介绍快速排序

- 第8章介绍了 基于”比较”排序的算法的下界为Ω(nlgn) 。并介绍了几种不基于比较的排序方法,它们能突破Ω(nlgn)的下界。计数排序、基数排序、桶排序。

- 第9章介绍了顺序统计的概念:第i个顺序统计是集合中第i小的数。并介绍了两个算法:

- 最坏情况为O(n^2),但平均情况下为线性O(n)的算法

- 最坏情况下为线性O(n)的算法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 | /**

* @file quick_sort.cpp

* @brief 归并排序

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <vector>

#include <algorithm>

#include <iterator>

#include <cassert>

using namespace std;

namespace ita {

void _MergeSort(vector<int> &v, int begin, int end) {

if (begin >= end) {

return;

}

int middle = begin + (end-begin)/2;

_MergeSort(v, begin, middle);

_MergeSort(v, middle + 1, end);

vector<int> out;

int i = begin;

int j = middle+1;

while (i <= middle && j <= end) {

if (v[i] < v[j]) {

out.push_back(v[i]);

++i;

} else {

out.push_back(v[j]);

++j;

}

}

if (i <= middle) {

out.insert(out.end(), v.begin() + i, v.begin() + middle + 1);

}

if (j <= end) {

out.insert(out.end(), v.begin() + j, v.begin() + end + 1);

}

for (int i = 0; i < out.size(); ++i) {

v[begin+i] = out[i];

}

}

void MergeSort(vector<int> &v) {

_MergeSort(v, 0, v.size() - 1);

}

}

int main() {

vector<int> v;

for (int i = 0; i < 30; ++i) {

v.push_back(rand() % 100);

}

copy(v.begin(), v.end(), ostream_iterator<int>(cout, " ")); cout << endl;

ita::MergeSort(v);

copy(v.begin(), v.end(), ostream_iterator<int>(cout, " ")); cout << endl;

return 0;

}

|

83 86 77 15 93 35 86 92 49 21 62 27 90 59 63 26 40 26 72 36 11 68 67 29 82 30 62 23 67 35

11 15 21 23 26 26 27 29 30 35 35 36 40 49 59 62 62 63 67 67 68 72 77 82 83 86 86 90 92 93

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 | /**

* @file binary_search.cpp

* @brief 二分查找

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <vector>

#include <algorithm>

#include <iterator>

#include <cassert>

using namespace std;

namespace ita {

bool BinarySearch(vector<int> const &vec, int begin, int end, int value) {

if (begin > end) {

return false;

}

int middle = begin + (end-begin)/2;

if (vec[middle] == value) {

return true;

}

if (value < vec[middle]) {

return BinarySearch(vec, begin, middle-1, value);

} else {

return BinarySearch(vec, middle+1, end, value);

}

}

}

int main() {

vector<int> v;

for (int i = 0; i < 20; ++i) {

v.push_back(rand() % 100);

}

sort(v.begin(), v.end());

copy(v.begin(), v.end(), ostream_iterator<int>(cout, " ")); cout << endl;

for (int i = 0; i < 100; ++i) {

cout << i << boolalpha << ita::BinarySearch(v, 0, v.size()-1, i) << "\t";

if ((i + 1) % 10 == 0) {

cout << endl;

}

}

return 0;

}

|

15 21 26 26 27 35 36 40 49 59 62 63 72 77 83 86 86 90 92 93

0false 1false 2false 3false 4false 5false 6false 7false 8false 9false

10false 11false 12false 13false 14false 15true 16false 17false 18false 19false

20false 21true 22false 23false 24false 25false 26true 27true 28false 29false

30false 31false 32false 33false 34false 35true 36true 37false 38false 39false

40true 41false 42false 43false 44false 45false 46false 47false 48false 49true

50false 51false 52false 53false 54false 55false 56false 57false 58false 59true

60false 61false 62true 63true 64false 65false 66false 67false 68false 69false

70false 71false 72true 73false 74false 75false 76false 77true 78false 79false

80false 81false 82false 83true 84false 85false 86true 87false 88false 89false

90true 91false 92true 93true 94false 95false 96false 97false 98false 99false

第6章:堆排序¶

- 堆排序是一个时间复杂度为O(nlgn)、原地排序算法。

- “堆”数据结构不只在推排序时有用,还可以构成一个有效 的优先队列 。

- 堆的定义是这样的:

- 一个堆是一颗完全二叉树

- 对于大(小)根堆,每个节点的值都比它的子节点要大(小)

- 虽然堆排的理论效率好,但是往往一个好的快排的实现要优于堆排。

- 所以堆更常见于作为高效的优先级队列(因为它是部分排序的,对于一个优先级队列来说,部分排序已经足够了):一个堆可以在O(lgn)的时间内,支持大小为n的集合上的任意优先队列的操作。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 | /**

* @file heap_sort.cpp

* @brief 堆的使用与堆排序

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <vector>

#include <algorithm>

#include <iterator>

#include "priority_queue.h"

using namespace std;

namespace ita {

/// @brief 保持堆的性质

///

/// 将to_make的[0,length)元素视为一棵完全二叉树,以第i个元素为根的子树除了第i个元素之外都满足大堆的性质

/// 调用此方法之后,这棵完全二叉树以第i个元素为根的子树都满足大堆的性质

/// @param to_make 保存数据的数组

/// @param length 标记to_make的[0,length)元素视为一个完全二叉树<br/>

/// 第length个元素之后[length, n)的元素不包括在这棵完全二叉树里

/// @param i 需要处理的第i个元素

/// @note to_make的前length个元素并不一定是一个堆(因为它不满足大堆的性质),但可以映射为完全二叉树

void MakeHeap( vector<int> &to_make, size_t length, size_t i ) {

size_t left = 2 * i + 1;

size_t right = 2 * i + 2;

size_t the_max = i;

if ( left < length && to_make[left] > to_make[i] ) {

the_max = left;

}

if ( right < length && to_make[right] > to_make[the_max] ) {

the_max = right;

}

if ( the_max != i ) {

std::swap( to_make[i], to_make[the_max] );

MakeHeap( to_make, length, the_max );

}

}

/// @brief 建堆

///

/// 将to_built数组改建成一个大头堆

void BuildHeap( vector<int> &to_built ) {

//这里只需要从to_built.size() / 2 - 1开始的原因在于:

//对叶子结点来说,它和它的子结点(为空)总是满足堆的定义的,所以只需要处理非叶子结点

for ( int i = to_built.size() / 2 - 1; i >= 0; --i ) {

MakeHeap( to_built, to_built.size(), i );

cout << endl;

copy( to_built.begin(), to_built.end(), ostream_iterator<int>( cout, " " ) );

}

}

/// 堆排序

void HeapSort( vector<int> &to_sort ) {

BuildHeap( to_sort );

for ( int i = to_sort.size() - 1; i > 0; --i ) {

std::swap( to_sort[0], to_sort[i] );

MakeHeap( to_sort, i, 0 );

cout << endl;

copy( to_sort.begin(), to_sort.end(), ostream_iterator<int>( cout, " " ) );

}

}

/// 测试 堆排序与优先队列 的实现

int testHeapSort() {

int to_init[] = {1, 2, 3, 4, 5, 6};

vector<int> to_sort( to_init, to_init + sizeof( to_init ) / sizeof( int ) );

cout << "原始数组,准备进行堆排序:";

copy( to_sort.begin(), to_sort.end(), ostream_iterator<int>( cout, " " ) );

HeapSort( to_sort );

cout << endl << "堆排序结束:";

copy( to_sort.begin(), to_sort.end(), ostream_iterator<int>( cout, " " ) );

cout << endl << endl;

cout << "初始化一个优先队列:";

PriorityQueue<int, greater<int>> queue;

for ( int i = 0; i < 10; ++i ) {

queue.Push( rand() % 1000 );

}

queue.Display();

cout << "开始不断的取最高优先级的任务出列:" << endl;

while ( !queue.IsEmpty() ) {

cout << queue.Top() << ":\t";

queue.Pop();

queue.Display();

}

cout << "开始添加任务入列:" << endl;

for ( size_t i = 0; i < to_sort.size(); ++i ) {

queue.Push( to_sort[i] );

queue.Display();

}

return 0;

}

}

int main() {

ita::testHeapSort();

return 0;

}

|

原始数组,准备进行堆排序:1 2 3 4 5 6

1 2 6 4 5 3

1 5 6 4 2 3

6 5 3 4 2 1

5 4 3 1 2 6

4 2 3 1 5 6

3 2 1 4 5 6

2 1 3 4 5 6

1 2 3 4 5 6

堆排序结束:1 2 3 4 5 6

初始化一个优先队列:335 421 383 649 492 777 386 915 793 886

开始不断的取最高优先级的任务出列:

335: 383 421 386 649 492 777 886 915 793

383: 386 421 777 649 492 793 886 915

386: 421 492 777 649 915 793 886

421: 492 649 777 886 915 793

492: 649 793 777 886 915

649: 777 793 915 886

777: 793 886 915

793: 886 915

886: 915

915:

开始添加任务入列:

1

1 2

1 2 3

1 2 3 4

1 2 3 4 5

1 2 3 4 5 6

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 | /**

* @file priority_queue.h

* @brief 优先队列

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <vector>

#include <algorithm>

#include <iterator>

#include <queue>

using namespace std;

namespace ita {

/// @brief 优先队列

///

/// 堆的主要应用之一:优先队列。\n

/// 优先级最高的元素在队首,其它的元素依赖于“比较子”满足大头堆的性质。

/// @param ItemType 队列中元素的类型

/// @param Comparator 用于比较队列中元素优先级的比较子

/// @param ContainerType 优先队列内部所使用的容器类型

/// @see void MakeHeap(vector<int> &, size_t , size_t)

/// @see void BuildHeap(vector<int> &)

/// @note 优先列队中的元素一旦被加入到队列中去了就不应该再修改;对于队列中的元素应该只支持Top, Pop, Push操作

template <

typename ItemType,

typename Comparator = less<ItemType>,

typename ContainerType = vector<ItemType >>

class PriorityQueue {

public:

typedef PriorityQueue<ItemType, Comparator, ContainerType> _MyType;

typedef ItemType & Reference;

typedef ItemType const & ConstReference;

/// 创建一个空的优先队列

PriorityQueue() {}

/// 由一个区间初始化一个优先队列

template<typename IterType>

PriorityQueue( IterType begin, IterType end ) : _queue( begin, end ) {

make_heap( _queue.begin(), _queue.end(), _comparator );

}

/// 向队列中添加一个元素

void Push( ItemType const &item ) {

_queue.push_back( item );

push_heap( _queue.begin(), _queue.end(), _comparator );

}

/// @brief 访问const的顶端元素

/// @return 优先级最高的队首元素的const引用

ConstReference Top() const {

return *_queue.begin();

}

/// @brief 访问非const的顶端元素

///

/// 在标准STL的优先队列实现中有这个非const方法,但是我认为不应该有这个方法,因为这样的话可以通过这个非const引用来修改Top Item的优先级,这样整个列队就可能不再具有一致性了!\n

/// 如果需要改变优先级,应该使用RefreshQueue里介绍的方法

/// @return 优先级最高的队首元素的<b>非const</b>引用

/// @see void RefreshQueue()

/// @deprecated <b>如果修改了队首元素的优先级,可能引起优先队列内部的不一致性</b>

Reference Top() {

return *_queue.begin();

}

/// 队首的元素出队

void Pop() {

pop_heap( _queue.begin(), _queue.end(), _comparator );

_queue.pop_back();

}

/// 查询队列是否为空

bool IsEmpty() {

return _queue.empty();

}

/// @brief 重新排序优先列队中的元素

///

/// 这个方法非常重要,有了这个方法之后优先列队就可以支持修改优先级的操作了。

/// @code

/// auto comparator = [](ItemType *item1, ItemType *item2){return item1->Priority() < item2->Priority();};

/// PriorityQueue<ItemType *, comparator> q;

/// items[6]->SetPriority(66); //从别处改变了某个元素的优先级

/// q.RefreshQueue(); //一定要记得调用RefreshQueue函数,否则在元素的优先级被外部修改之后优先队列的内部状态将不一致! ///

/// @endcode

void RefreshQueue() {

make_heap( _queue.begin(), _queue.end(), _comparator );

}

/// 将队列中所有的元素显示的输出流中

void Display() {

copy( _queue.begin(), _queue.end(), ostream_iterator<ItemType>( cout, " " ) );

cout << endl;

}

private:

ContainerType _queue; ///< 容器

Comparator _comparator; ///< 比较子

};

}

|

第7章:快速排序¶

- 快速排序的最坏运行时间为O(n2),期望运行时间为O(nlgn) ,且由于O(nlgn)中 隐含的常数因子很小 ,所以快排通常是用于排序的最佳的实用选择(因为其平均性能非常好)。

- 快排真的太棒了:算法实现简单易懂、平均性能非常好、原地排序不需要额外的空间、算法简单只需要寥寥几行就搞定(比冒泡还少)。

- 对10W个随机数进行排序比较,快排平均在600MS,而堆排平均在900MS,性能差距可见一斑啊。

- 快排的平均情况运行时间与其最佳情况运行时间很接近,而不是非常接近于其最坏情况运行时间,所以一般来说快排效率是最高的,这是快排在现代得以大规模的使用的根本原因。

- 快排很需要随机化技术 :因为在真正的应用时很容易出现待排序的数组其实已经是有序的情况,而这种已经有序的情况却正好又是快排算法的软肋,它在待排数组有序时的效率是最差的O(n^2),所以很需要随机化技术!

快速排序的预随机化 :正如第5章所说的,由于工程中的输入可能不随机的,所以我们要将其随机化。有两种可选方案

- 直接对输入数据进行随机化排列

- 采用随机取样的随机化技术。随机取样的效率更高一些,所以在快速排序的随机化版本中采用随机取样的技术。

方法很简单,就是在每趟sort之前随机选取一个数与最未尾的元素进行交换操作,这样简单高效的实现了随机化:

//加入随机取样的随机化技术 int random_swap = (rand() % (EndIndex - BeginIndex + 1)) + BeginIndex; std::swap(ToSort[random_swap], ToSort[EndIndex]);这个技术太有用啊,因为快速排序在输入数据已经有序时的性能是最差的,但是 输入数据已经有序的情况又会经常发生,所以这个随机取样就显得异常的重要 。如果没有这个随机取样,快排绝得不到这样的应用。 在我做的实验中,对2000个有序的数据进行排序,在未没采用随机化的情况下,平均耗时860MS,而使用了随机取样之后平均耗时8MS,效率提高了100倍。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 | /**

* @file quick_sort.cpp

* @brief 快速排序

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <vector>

#include <iostream>

#include <iterator>

#include <ctime>

#include <algorithm>

using namespace std;

namespace ita {

/// @brief 采用了随机取样技术的快速排序

///

/// 快速排序的平均效率为O(nlgn),最坏情况为O(n^2)

void QuickSort( vector<int> &ToSort, int BeginIndex, int EndIndex ) {

if ( BeginIndex < EndIndex ) {

//加入随机取样的随机化技术

//一定要使用,对平均性能的提升作用太大了

int random_swap = ( rand() % ( EndIndex - BeginIndex + 1 ) ) + BeginIndex;

std::swap( ToSort[random_swap], ToSort[EndIndex] );

//i代表的是比ToSort[EndIndex]小的元素的上界,即ToSort[BeginIndex,i)的元素值都比ToSort[EndIndex]要小

//也意味着下一个比ToSort[EndIndex]小的元素要放置的位置;但是在当前可能ToSort[i] >= ToSort[EndIndex]

int i = BeginIndex;

//j代表已经检查过的元素的上界

for ( int j = BeginIndex; j != EndIndex; ++j ) {

//找到满足比ToSort[EndIndex]小的元素

if ( ToSort[j] < ToSort[EndIndex] ) {

swap( ToSort[i], ToSort[j] ); //将这个比ToSort[EndIndex]小的元素移到第i个去,满足了i代表的意义

++i; //由于新找到了一个比ToSort[EndIndex]小的元素,所以上界应该+1

}

}

swap( ToSort[i], ToSort[EndIndex] );

QuickSort( ToSort, BeginIndex, i - 1 );

QuickSort( ToSort, i + 1, EndIndex );

}

}

/// @brief 对模糊区间的快速排序

///

/// 问题描述: (算法导论7-6题)\n

/// 考虑这样的一种排序问题,即无法准确地知道待排序的各个数字到底是多少。对于其中的每个数字,

/// 我们只知道它落在实轴上的某个区间内。亦即,给定的是n个形如[a(i), b(i)]的闭区间(这里小括

/// 后起下标的作用,后同),其中a(i) <= b(i)。算法的目标是对这些区间进行模糊排序

/// (fuzzy-sort),亦即,产生各区间的一个排列<i(1), i(2), ..., i(n)>,使得存在一个c(j)属于

/// 区间[a(i(j)), b(i(j))],满足c(1) <= c(2) <= c(3) <= ... <= c(n)。 :\n

/// - 为n个区间的模糊排序设计一个算法。你的算法应该具有算法的一般结构,它可以快速排序左部

/// 端点(即各a(i)),也要能充分利用重叠区间来改善运行时间。(随着各区间重叠得越来越多,

/// 对各区间进行模糊排序的问题会变得越来越容易。你的算法应能充分利用这种重叠。) \n

/// - 证明:在一般情况下,你的算法的期望运行时间为Θ(nlgn),但当所有的区间都重叠时,期望的

/// 运行时间为Θ(n)(亦即,当存在一个值x,使得对所有的i,都有x∈[a(i), b(i)])。你的算法

/// 不应显式地检查这种情况,而是应随着重叠量的增加,性能自然地有所改善。

void SmoothQuickSort( vector< pair<int, int> > &to_sort, int begin_index, int end_index ) {

if ( begin_index < end_index ) {

//取最后一个区间为主元

auto principal = to_sort[end_index];

//获取要比较的区间(除去主元)为[begin_index, end_index) => [i,j]

//区间[i,j]意思是:其中所有的元素要不还未处理,要不相互重叠有至少一个重叠值,并且该值还与to_sort[end_index]重叠

//即在题目中规定的语义下与to_sort[end_index]绝对相等

int i = begin_index;

int j = end_index - 1;

for ( int k = begin_index; k <= j; ) { //k为当前正在处理的元素

if ( to_sort[k].second <= principal.first ) {

//严格小于主元

swap( to_sort[i], to_sort[k] );

++i;

++k;

} else if ( to_sort[k].first >= principal.second ) {

//严格大于主元

swap( to_sort[j], to_sort[k] );

--j;

} else {

// 与主元区间有重叠,则更新主元为重叠区间(交集)

// 此方法参考了 http://blogold.chinaunix.net/u/18517/showart_487873.html

//

// 这种想法真的好,因为缩小了主元的区间(交集),所以就可以认为以后任何与缩小之后主元有重叠

// 的区间都一定与当前区间to_sort[k]重叠(因为它完全包括缩小后的主元)\n

// 因此这样就可以确定最后在[i,j]中的所有元素在本题的约定下与主元绝对相等(即所有的元素相互

// 重叠),所以不需要再处理。这就符合了题目中的“充分利用重叠区间来改善运行时间”\n

// 如果没有这步缩小区间,就只能认为[i,j]中的元素各自与主元有重叠而无法判断为绝对相等。

// @note 这里很容易弄错的一点是:区间重叠并没有传递性,重叠区间的元素并不能认为是已序的

principal.first = max( to_sort[k].first, principal.first );

principal.second = min( to_sort[k].second, principal.second );

++k;

}

}

swap( to_sort[j + 1], to_sort[end_index] );

SmoothQuickSort( to_sort, begin_index, i - 1 );

SmoothQuickSort( to_sort, j + 2, end_index );

}

}

/// 测试快速排序和对模糊区间的快速排序

int testQuickSort() {

cout << "==========================快速排序=============================" << endl;

vector<int> ToSort;

for ( int i = 0; i < 20; ++i ) {

ToSort.push_back( rand() % 100 );

}

cout << "随机填充100个数:" << endl;

copy( ToSort.begin(), ToSort.end(), ostream_iterator<int>( cout, " " ) );

QuickSort( ToSort, 0, ToSort.size() - 1 );

cout << endl << "快速排序的结果如下:" << endl;

copy( ToSort.begin(), ToSort.end(), ostream_iterator<int>( cout, " " ) );

cout << endl << "======================模糊区间的快速排序=========================" << endl;

vector< pair<int, int> > to_sort_smooth;

for ( int i = 0; i < 10; ++i ) {

int b = rand() % 100;

to_sort_smooth.push_back( make_pair( b, b + rand() % 100 ) );

}

SmoothQuickSort( to_sort_smooth, 0, to_sort_smooth.size() - 1 );

for_each( to_sort_smooth.begin(), to_sort_smooth.end(), []( pair<int, int> &p ) {

cout << p.first << "\t --> \t" << p.second << endl;

} );

return 0;

}

}

int main() {

ita::testQuickSort();

return 0;

}

|

==========================快速排序=============================

随机填充100个数:

83 86 77 15 93 35 86 92 49 21 62 27 90 59 63 26 40 26 72 36

快速排序的结果如下:

15 21 26 26 27 35 36 40 49 59 62 63 72 77 83 86 86 90 92 93

======================模糊区间的快速排序=========================

24 --> 39

56 --> 67

58 --> 127

42 --> 71

70 --> 83

19 --> 103

37 --> 135

67 --> 160

26 --> 117

73 --> 94

第8章:线性时间排序¶

- 任何 比较的排序在最坏的情况下都要用Ω(nlgn)次 比较来进行排序,所以合并排序和堆排序是渐近最优的。

- 注意的是: 快排不是渐近最优的,因为它在最坏的情况下是O(n2) 。

- 三种以线性时间运行的排序算法:计数排序、基数排序和桶排序。 它们都是非比较的

- 计数排序

- 步骤:统计每一种元素的出现次数,然后再从有序的按出现次数输出,所得的结果就的原数列的有序排列。

- 计数排序的一个重要性就是它是稳定的排序算法,这个稳定性是基数排序的基石。

- 计数排序的想法真的很简单、高效、可靠

- 缺点在于:

- 需要很多额外的空间(当前类型的值的范围)

- 只能对离散的类型有效比如int(double就不行了)

- 基于假设:输入是小范围内的整数构成的。

- 基数排序

- 步骤:按低纬度到高纬度的把元素放到桶中,再收集起来,完成最高纬度之后,收集的结果就已经是有序的了。

- 基数排序时对每一维进行调用子排序算法时要求这个子排序算法必须是稳定的。

- 基数排序与直觉相反:它是按照从底位到高位的顺序排序的。

- 我觉得原因在于:高有效位对底有效位有着决定性的作用;后面的排序对前面的排序起决定性的作用。

- 基于假设:位数有限,并且也是离散的值分布。

- 桶排序

- 桶排序也 只是期望运行时间能达到线性 ,对于最坏的情况,它的运行时间取决于它内部使用的子排序算法的运行时间,一般为O(nlgn)。

- 桶排序基于假设:输入的的元素均匀的分布在区间[0, 1]上。

- 感觉桶排没有什么大的实现价值,因为它限定了输入的区间,还要求最好是均匀分布,它的最坏情况并不好。

- 所有的 线性时间内的排序算法,都作出了一定的假设,是建立在一定的假设基础上 的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 | /**

* @file linear_sort.cpp

* @brief 线性时间排序算法

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <algorithm>

#include <vector>

#include <iterator>

using namespace std;

namespace ita {

/// @brief 计数排序

///

/// 计数排序的思想是:假定所有的元素都处于[0, k_max_size)区间,然后在n的时间内统计所有的元素的个数。\n

/// 有了这些元素的个数信息之后,就可以重构出它们的排序结果了。\n

/// 计数排序的特征:

/// - 计数排序的一个重要性就是它是稳定的排序算法,这个稳定性是基数排序的基石。

/// - 计数排序的想法真的很简单、高效、可靠

/// - 缺点在于:

/// -# 需要很多额外的空间(当前类型的值的范围)

/// -# 只能对离散的类型有效比如int(double就不行了)

/// -# 基于假设:输入是小范围内的整数构成的。

void CountingSort() {

int const k_max_size = 100; //待排序的所有元素都必须位于区间[0, k_max_size)

//初始化区间为[0, k_max_size)之间的随机数作为输入

std::vector<int> v;

for ( int i = 0; i < 15; ++i ) {

v.push_back( rand() % k_max_size );

}

//进行计数 c[i] = j代表着i在输入数据中出现了j次

std::vector<int> c( k_max_size, 0 );

std::for_each( v.begin(), v.end(), [&]( int i ) {

++c[i];

} );

//对所有的计数从依次总结出最后的排序,并没有使用原书上的方法

//比书上的算法更直接,将二步合成了一步,效率上是同样的渐近时间复杂度的,似乎更好点。

v.clear();

for ( int i = 0; i < k_max_size; ++i ) {

for ( int k = 0; k < c[i]; ++k ) {

v.push_back( i );

}

}

copy( v.begin(), v.end(), std::ostream_iterator<int>( std::cout, " " ) );

}

/// @brief 基数排序

///

/// 基数排序就是按照从底位到高位的顺序依次选取待排序的元素,然后在稳定的前提下放入下一次排序之中,和放扑克牌很相似。

/// - 基数排序时对每一维进行调用子排序算法时要求这个子排序算法必须是稳定的。

/// - 基数排序与直觉相反:它是按照从底位到高位的顺序排序的。\n

/// 我觉得原因在于:高有效位对底有效位有着决定性的作用。

/// @note 基数排序内部所使用的子排序算法必须是稳定的

void RadixSort(std::vector<int> &v) {

int max_dim = 0;

for (int i = 0; i < v.size(); ++i) {

int dim = 0;

int j = v[i];

while (j > 0) {

++dim;

j /= 10;

}

max_dim = max(max_dim, dim);

}

cout << "max dim = " << max_dim << endl;

//得到一个数的某一维的值

//eg: GetDim(987, 0) = 7

// GetDim(987, 1) = 8

// GetDim(987, 2) = 9

auto GetDim = []( int number, int d ) -> int {

for ( int i = 0; i < d; ++i ) {

number /= 10;

}

return number % 10;

};

int dim = 0;

while (dim < max_dim) {

vector<vector<int>> barrel(10);

for (int i = 0; i < v.size(); ++i) {

barrel[GetDim(v[i], dim)].push_back(v[i]);

}

v.clear();

for (int i = 0; i < barrel.size(); ++i) {

v.insert(v.end(), barrel[i].begin(), barrel[i].end());

}

++dim;

}

}

/// 基数排序算法的初始化和调用

void RadixSortCaller() {

//初始化[0,999]之间的随机数作为输入

std::vector<int> v;

for ( int i = 0; i < 10; ++i ) {

v.push_back( rand() % 100);

}

std::copy( v.begin(), v.end(), std::ostream_iterator<int>( std::cout, " " ) );

std::cout << std::endl;

RadixSort( v );

std::copy( v.begin(), v.end(), std::ostream_iterator<int>( std::cout, " " ) );

}

/// @brief 桶排序

///

/// 桶排序的算法步骤:

/// - 构建桶,并将所有的元素放入到相应的桶中去;\n

/// 比如(0.21 0.45 0.24 0.72 0.7 0.29 0.77 0.73 0.97 0.12)根据它们的小数点后第1位,放入到相应的10个桶中去

/// - 对每一个桶里的元素进行排序\n

/// 比如对于桶2,其中有2个元素0.21, 0,24。 对它们进行好内部排序。

/// - 依次把每个桶中的元素提取出来并组合在一起\n

/// 得到最后的结果(0.12 0.21 0.24 0.29 0.45 0.7 0.72 0.73 0.77 0.97)

///

/// 桶排序也只是期望运行时间能达到线性,对于最坏的情况,它的运行时间取决于它内部使用的子排序算法的运行时间,一般为O(nlgn)。

/// - 桶排序基于假设:输入的的元素均匀的分布在区间[0, 1]上。

/// - 感觉桶排没有什么大的实现价值,因为它限定了输入的区间,还要求最好是均匀分布,它的最坏情况并不好。

void BucketSort() {

//初始化[0,1)之间的随机数

vector<double> v;

for ( int i = 0; i < 10; ++i ) {

v.push_back( ( rand() % 100 ) * 1.0 / 100.0 );

}

copy( v.begin(), v.end(), ostream_iterator<double>( cout, " " ) );

cout << endl;

//构建桶,并将所有的元素放入到相应的桶中去

vector< vector<double> > bucket( 10 ); //10个桶

for_each( v.begin(), v.end(), [&]( double d ) {

bucket[d * 10].push_back( d );

} );

//对每一个桶里的元素进行排序

for_each( bucket.begin(), bucket.end(), []( vector<double> &sub_v ) {

sort( sub_v.begin(), sub_v.end() );

} );

//依次把每个桶中的元素提取出来并组合在一起

v.clear();

for_each( bucket.begin(), bucket.end(), [&]( vector<double> &sub_v ) {

v.insert( v.end(), sub_v.begin(), sub_v.end() );

} );

copy( v.begin(), v.end(), ostream_iterator<double>( cout, " " ) );

}

/// 测试计数排序 基数排序 桶排序

int testLinearSort() {

cout << endl << "===========开始计数排序===========" << endl;

CountingSort();

cout << endl << "===========开始基数排序===========" << endl;

RadixSortCaller();

cout << endl << "===========开始桶排序===========" << endl;

BucketSort();

return 0;

}

}

int main() {

ita::testLinearSort();

return 0;

}

|

===========开始计数排序===========

15 21 27 35 49 59 62 63 77 83 86 86 90 92 93

===========开始基数排序===========

26 40 26 72 36 11 68 67 29 82

max dim = 2

11 26 26 29 36 40 67 68 72 82

===========开始桶排序===========

0.3 0.62 0.23 0.67 0.35 0.29 0.02 0.22 0.58 0.69

0.02 0.22 0.23 0.29 0.3 0.35 0.58 0.62 0.67 0.69

第9章:中位数和顺序统计学¶

- 第i个顺序统计量是该集合中第i小的元素。

最小值是第1个顺序统计量(i=1)最大值是第n个顺序统计量(i=n)

中位数是它所在集合的”中点元素”

- 同时找出最大最小值的算法 ,一般人可能以为需要2n次比较, 实际上只需要至多3n/2次比较 ,使用的技巧是:

将一对元素比较,然后把较大者于max比较,较小者与min比较,这样就只需要3n/2次比较就能得到最后的结果。

以期望线性时间选择顺序统计量的方法是以快速排序为模型

如同在快速排序中一样,此算法的思想也是对输入数组进行递归划分。 但和快速排序不同的是,快速排序会递归处理划分的两边,而randomized-select只处理划分的一边 (因为完全没有必要处理另外一边嘛)。 并由此将期望的运行时间由O(nlgn)下降到了O(n),但是最坏情况依然是O(n2 ),虽然这样的最坏情况几乎不会发生,特别是加上随机取样技术之后。

这就是顺序统计量算法能够如此高效的核心原因所在! 我觉得

C++ STL中的nth_element用的可能就是这个算法,所以它的效率应该很高。- 最坏线性时间选择顺序统计量的方法的核心在于:要保证对数组的划分是一个好的划分。

于是方法使用了一个很奇怪的取主元的方法(而不是直接取最后一个或者随机),虽然看起来很奇怪,但是该方法被这样的提出就肯定有它的理论基础的。 不过这种取巧的方法不太值得去写一遍,而且明显写出来也很容易的(仅仅相差一个奇怪的取主元方法,这一节的关键内容都在于证明这个方法的最坏线性时间上了),没有什么新技术和新想法。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 | /**

* @file nth_element.cpp

* @brief 中位数和顺序统计学

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <algorithm>

#include <vector>

#include <iterator>

using namespace std;

namespace ita {

namespace {

/// 寻找v数组的子集[begin_index, end_index]中的第i个元素顺序统计量,0 <= i < end_index-begin_index

int _NthElement( vector<int> &v, int const begin_index, int const end_index, int const n ) {

//这个判断纯粹只是一个加速return的技巧,没有这个判断算法也是正确的!

if ( begin_index == end_index ) {

return v[begin_index];

}

//随机取样

int swap_index = rand() % ( end_index - begin_index + 1 ) + begin_index;

swap( v[swap_index], v[end_index] );

//根据最后一个主元进行分割成两部分

int i = begin_index;

for ( int j = begin_index; j < end_index; ++j ) {

if ( v[j] < v[end_index] ) {

swap( v[i++], v[j] );

}

}

swap( v[i], v[end_index] );

//主元是本区间的第k个元素顺序统计量,0<=k<size

int k = i - begin_index;

if ( n == k ) {

//找到了

return v[i];

}

if ( n < k ) {

//在左区间继续找

return _NthElement( v, begin_index, i - 1, n );

} else {

//在右区间继续找:由于主元是第k个元素顺序统计量(0<=k<size),所以小于等于主元的元素有k+1个(包括主元),因此寻找右区间的第n-(k+1)个顺序统计量

return _NthElement( v, i + 1, end_index, n - k - 1 );

}

}

}

/// @brief 寻找v数组中的第i个顺序统计量,0<=i<size

///

/// 以快速排序为模型。如同在快速排序中一样,此算法的思想也是

/// 对输入数组进行递归划分。但和快速排序不同的是,快速排序会递归处理划分的两边,而randomized-select

/// 只处理划分的一边。并由此将期望的运行时间由O(nlgn)下降到了O(n)。

/// @param v 要进行查找操作的集合

/// @param i 查找集合中的第i个顺序统计量

/// @return 集合中的第i个顺序统计量

/// @see int _NthElement(vector<int> &v, int const begin_index, int const end_index, int const n)

int NthElement( vector<int> &v, int const i ) {

return _NthElement( v, 0, v.size() - 1, i );

}

/// 中位数和顺序统计学

int testNthElement() {

vector<int> v;

for ( int i = 0; i < 10; ++i ) {

v.push_back( ( rand() % 1000 ) );

}

copy( v.begin(), v.end(), ostream_iterator<int>( cout, " " ) );

cout << endl;

for ( int i = 0; i < 10; ++i ) {

cout << i << "th element is:" << NthElement( v, i ) << endl;

}

return 0;

}

}

int main() {

ita::testNthElement();

return 0;

}

|

383 886 777 915 793 335 386 492 649 421

0th element is:335

1th element is:383

2th element is:386

3th element is:421

4th element is:492

5th element is:649

6th element is:777

7th element is:793

8th element is:886

9th element is:915

第三部分:数据结构¶

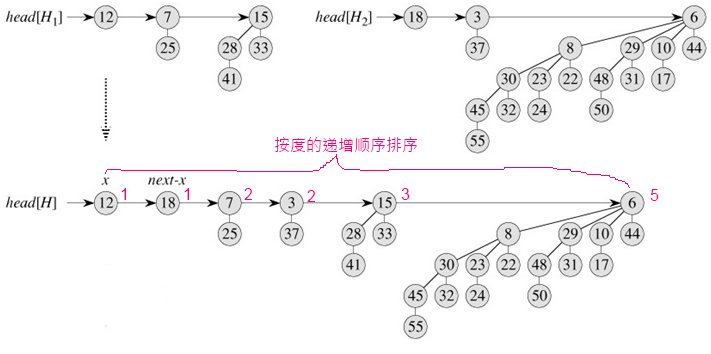

第11章:散列表¶

- 在散列表中查找一个元素的时间与在链表中查找一个元素的时候相同,在 最坏情况为O(n),但期望时间为O(1)

在实践中,散列表的效率是很高的,一般可认为是O(1)

散列是一种极其有效和实用的技术:基本的字典操作只需要O(1)的平均时间。 而且当待排序的关键字的集合是静态的(即当关键字集合一旦存入后不需要再改变),”完全散列”能够在O(1)的最坏时间内支持查找操作

在众多的简单的解决碰撞的方法中,我觉得比较好的是通过链表法解决碰撞,虽然这个方法的理论最坏效率为O(n),但是在平均情况下,它的性能也是非常好的,实现简单又高效。

装载因子 :给定一个能存放n个元素的、具有m个槽位的散列表T,定义T的装载因子α=n/m,即一个链中平均存储的元素数。

多数的散列函数都假定关键字域为自然数集N,如果所给关键字不是自然数,则必须有一种方法来将它们解释为自然数。

- 除法散列法:h(k)= k mod m

- 一般选取m的值为与2的整数幂不大接近的质数

- 乘法散列法:h(k)= m(kA mod 1)

- 构造散列函数的乘法方法包含两个步骤:首先用关键字剩上常数A(0<A<1),并抽取kA的小数部分;然后用m剩以这个值,再取结果的底。 Knuth认为A≈5-12是一个比较理想的值。

- 全域散列:全域散列的基本思想是 在执行开始时,就从一族仔细设计的函数中,随机地选择一个作为散列函数

- 首先:全域散列表是一种使用”键接法”来解决碰撞问题的散列表方法。

- 随机化保证了对于任何输入,算法都具有较好的平均性能。

- 全域的散列函数组:设H为一组散列函数,它将给定的关键字域U映射到{0,1,…,m-1}中,这样的一个函数组称为是全域的。如果从H中随机地选择一个散列函数,当关键字K≠J时,两者发生碰撞的概率不大于1/m。

- 常用的一个全域散列函数类:( 数论的知识可以证明这个函数类满足全域散列函数的性质,我只要相信这个常用的函数可以被证明就可以了! )

- 首先选择一个足够大的质数p ,使得每一个可能的关键字k 都落到0 到p-1 的范围内,包括首尾的0 和p-1。 这里我们假设全域是0 – 15,p 为17。设集合Zp 为{0, 1, 2, …, p-1},集合Zp* 为{1, 2, 3, …, p}。 由于p 是质数,我们可以定义散列函数h(a, b, k) = ((a*k + b) mod p) mod m。其中a 属于Zp,b 属于Zp*。 由所有这样的a 和b 构成的散列函数,组成了函数簇。即全域散列。

- 明白这个散列函数的选取是在 执行开始 随机的选取一个是很重要的,要不然就会不明白到时候怎么进行查找 这里所谓的随机性应该这样理解:对于某一个散列表来说,它在初始化时已经把a,b固定了,但是对于一个还未初始化的全域散列表来说,a,b是随机选取的。

开放寻址法:所有的元素都放在散列表里

- 开放寻址法的好处就在于它根本不用指针,而是计算出要存取的各个槽。这样一来,由于不用存储指针就节省了空间,从而可以用同样的空间来提供更多的槽,其潜在的效果就是可以减少碰撞,提高查找速度。

- 感觉上开放寻址法很像一个启发式的搜索 ,它的最坏性能也是O(n),只不过散列函数为它提供了启发信息从而使得一般的平均性能会很好。

- 在开放寻址法中,对散列元素的删除操作执行起来比较困难,因为删除操作会影响查找操作。解决办法是在槽里的值被删除后置一个特定的值DELETED,而不是删除后不管,查找的时候处理一下就可以了

- 线性探查、二次探查和双重散列都是对最基本的数组法的改进,虽然它们很漂亮,但是思想上并没有太大的革新,看起来很容易懂的。

- 双重散钱是用于开放寻址的最好方法之一,因为它所产生的排列具有随机选择的排列的许多特性。

- 所有的改进的散列方法目的只有一个: 都是在尽力地增加散列结果的随机性 !

- 完全散列 :如果某一种散列技术在进行查找时,其最坏情况内存访问次数为O(1)的话,则称其为完全散列。

- 书上利用了一种 两级的散列方案,每一级都采用全域散列 。通常利用一种两级的散列方案,每一级上都采用全域散列。为了 确保在第二级上不出现碰撞 ,需要让第二级散列表Sj的大小mj为散列到槽j中的关键字数nj的平方。如果利用从某一全域散列函数类中随机选出的散列函数h,来将n个关键字存储到一个大小为m=n的散列表中,并将每个二次散列表的大小置为mj=nj2 (j=0, 1, …, m-1),则在一个完全散列方案中,存储所有二次散列表所需的存储总量的期望值小于2n。完全散列的关键在于:二次散列表中要求没有碰撞!这是通过确保槽的个数是关键字的个数的平方来实现的,第一次散列时要求的槽数为关键字的个数,第二次散列时要求的槽数为当前槽中被分配的关键字的个数的平方。完全散列的关键在于是对:静态的关键字集合,关键字集合不但不能增加,甚至减少都不行,因为二级散列的槽的个数为散列到该二级散列所在的一级槽中元素的个数的平方。这种二次散列时要求N2的空间要求似乎感觉会使得完全散列会对空间需求太大,实际上,通过合适的选取第一次的散列函数,总存储空间的预期仍然为O(n)。

完全散列的核心在于: 将N个关键值散列到 N2个的槽中,就一定可以找到一个无碰撞的散列函数来提供常量级别的查找时间 (空间换时间嘛) 。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 | /**

* @file hash_table.cpp

* @brief 散列表

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <algorithm>

#include <vector>

#include <iterator>

#include <iomanip>

#include <limits>

using namespace std;

namespace ita {

/// @brief Noraml Hash Table

template<typename T>

class HashTable {

struct Node {

T value;

Node *pre;

Node *next;

};

public:

explicit HashTable(int n) : data_(n, nullptr) {

}

~HashTable() {

for (Node *n : data_) {

while (n) {

Node *p = n;

n = n->next;

delete p;

}

}

}

Node* Find(T const &v) {

Node *p = data_[GetHashValue(v)];

while (p) {

if (p->value == v) {

return p;

}

p = p->next;

}

return nullptr;

}

bool Insert(T const &v){

if (Find(v) != nullptr) {

return false;

}

int shared = GetHashValue(v);

Node *old_node = data_[shared];

Node *new_node = new Node();

new_node->value = v;

new_node->pre = nullptr;

new_node->next = old_node;

if (old_node != nullptr) {

old_node->pre = new_node;

}

data_[shared] = new_node;

return true;

}

bool Delete(T const &v) {

Node *p = Find(v);

if (p == nullptr) {

return false;

}

if (p->pre == nullptr) {

data_[GetHashValue(v)] = p->next;

} else {

p->pre->next = p->next;

}

if (p->next != nullptr) {

p->next->pre = p->pre;

}

delete p;

p = nullptr;

return true;

}

void Display() {

for (int i = 0; i < data_.size(); ++i) {

cout << "槽[" << setw( 3 ) << i << setw( 3 ) << "] ";

Node *p = data_[i];

while (p) {

cout << " --> " << p->value;

p = p->next;

}

cout << endl;

}

cout << endl;

}

private:

int GetHashValue(T const &v) {

return v % data_.size();

}

vector<Node*> data_;

};

/// @brief 全域散列表

///

/// - 全域散列表是一种使用“键接法”来解决碰撞问题的散列表方法。\n

/// - 随机化保证了对于任何输入,算法都具有较好的平均性能。\n

/// - 全域的散列函数组:设H为一组散列函数,它将给定的关键字域U映射到{0,1,…,m-1}

/// 中,这样的一个函数组称为是全域的。如果从H中随机地选择一个散列函数,当关键

/// 字K≠J时,两者发生碰撞的概率不大于1/m。

/// - 明白这个散列函数的选取是在“<b>执行开始</b>”随机的选取一个是很重要的,要

/// 不然就会不明白到时候怎么进行查找。\n

/// 这里所谓的随机性应该这样理解:对于某一个散列表来说,它在初始化时已经把a,b

/// 固定了,但是对于一个还未初始化的全域散列表来说,a,b是随机选取的。

///

/// 全域散列函数类,首先选择一个足够大的质数p ,使得每一个可能的关键字k 都落到0 到p-1 的范围内,包括首尾的0 和p-1。\n

/// 这里我们假设全域是0 – 15,p 为17。设集合Zp 为{0, 1, 2, …, p-1},集合Zp* 为{1, 2, 3, …, p-1}。\n

/// 由于p 是质数,我们可以定义散列函数\n

/// h(a, b, k) = ((a*k + b) mod p) mod m\n

/// 其中a 属于Zp,b 属于Zp*。由所有这样的a 和b 构成的散列函数,组成了函数簇。即全域散列。\n

/// 全域散列的基本思想是在执行<b>开始</b>时,从一族仔细设计的函数中,随机的选择一个作为散列函数。\n

/// 使之独立于要存储的关键字。不管对手选择了怎样的关键字,其平均性态都很好。\n

/// @param T 散列表里要存储的元素类型

template<typename T>

class UniversalHashTable {

public:

/// 构造一个全域散列表,同时从一族仔细设计的函数中,随机的选择一个作为散列函数。

UniversalHashTable() {

_p = 101; //一个足够大的质数

_m = 10; //槽的个数

_items.resize( _m, nullptr );

for ( int i = 0; i < _m; ++i ) {

//全部先设置好头结点

_items[i] = new _Node();

_items[i]->Next = nullptr;

}

// 全域散列的基本思想是在执行<b>开始</b>时,从一族仔细设计的函数中,随机的选择一个作为散列函数。

_a = rand() % ( _p - 1 ) + 1;

_b = rand() % _p;

}

~UniversalHashTable() {

for_each( _items.begin(), _items.end(), []( _Node * item ) {

while ( item ) {

auto next = item->Next;

delete item;

item = next;

}

} );

}

/// 向散列表中插入一个元素

void Insert( T const &new_value ) {

//始终插入在键表的头,头结点之后的第1个位置

_Node *new_item = new _Node;

new_item->Item = new_value;

new_item->Next = nullptr;

int hash_value = _HashFunction( new_value );

new_item->Next = _items[hash_value]->Next;

_items[hash_value]->Next = new_item;

}

/// @brief 从散列表中删除一个元素

///

/// @return 是否成功的删除这样的元素

bool Delete( T const &delete_value ) {

int hash_value = _HashFunction( delete_value );

_Node *root = _items[hash_value];

while ( root->Next ) {

if ( root->Next->Item == delete_value ) {

auto temp = root->Next;

root->Next = root->Next->Next;

delete temp;

return true;

} else {

root = root->Next;

}

}

return false;

}

/// 在散列表中搜索一个元素

T * Search( T const &search_value ) {

int hash_value = _HashFunction( search_value );

_Node *root = _items[hash_value]->Next;

while ( root ) {

if ( root->Item == search_value ) {

return &( root->Item );

}

root = root->Next;

}

return nullptr;

}

/// 将散列表中的所有的元素显示在输出流中

void Display() {

for ( int i = 0; i < _m; ++i ) {

_Node *item = _items[i]->Next; //跳过头结点

cout << "槽[" << setw( 3 ) << i << setw( 3 ) << "]";

while ( item ) {

cout << " -> " << item->Item;

item = item->Next;

}

cout << endl;

}

}

private:

/// @brief 节点(使用单键表)

///

/// 要是用双键表就会方便很多啊

struct _Node {

T Item;

_Node *Next;

};

/// @brief 全域散列函数

///

/// 本函数、一开始时随机选取_a,_b、再加上选取_p,_m的方法,就是全域散列的核心所在!!!

/// h(a, b, k) = ((a*k + b) mod p) mod m

int _HashFunction( T k ) {

return static_cast<int>( _a * k + _b ) % _p % _m;

}

int _p, _m, _a, _b; ///< 全域散列表的各个参数

vector<_Node *> _items; ///< 槽:存储真正的键表,使用的是带头结点的单键表

};

/// 测试全域散列表类

int testUniversalHashTable() {

UniversalHashTable<int> table;

cout << "开始往UniversalHashTable里添加内容[0,100):" << endl;

for ( int i = 0; i < 100; ++i ) {

table.Insert( i );

}

table.Display();

cout << "开始删除内容[0,5):" << endl;

for ( int i = 0; i < 5; ++i ) {

table.Delete( i );

}

table.Display();

for ( int i = 0; i < 10; ++i ) {

auto finded = table.Search( i );

cout << "开始检索结点[" << i << "]:";

if ( finded ) {

cout << *finded << endl;

} else {

cout << "未找到" << endl;

}

}

return 0;

}

int testNormalHashTable() {

HashTable<int> ht(10);

for (int i = 0; i < 20; ++i) {

ht.Insert(rand() % 100);

}

ht.Display();

for (int i = 0; i < 50; ++i) {

ht.Delete(i);

}

ht.Display();

for (int i = 0; i < 20; ++i) {

ht.Insert(rand() % 100);

}

ht.Display();

}

}

int main() {

ita::testUniversalHashTable();

cout << "=============================================" << endl;

ita::testNormalHashTable();

return 0;

}

|

开始往UniversalHashTable里添加内容[0,100):

槽[ 0 ] -> 97 -> 94 -> 91 -> 75 -> 72 -> 56 -> 53 -> 34 -> 31 -> 15 -> 12

槽[ 1 ] -> 88 -> 85 -> 69 -> 66 -> 50 -> 47 -> 28 -> 25 -> 9 -> 6

槽[ 2 ] -> 82 -> 79 -> 63 -> 60 -> 44 -> 41 -> 22 -> 19 -> 3 -> 0

槽[ 3 ] -> 98 -> 95 -> 76 -> 73 -> 57 -> 54 -> 38 -> 35 -> 16 -> 13

槽[ 4 ] -> 92 -> 89 -> 70 -> 67 -> 51 -> 48 -> 32 -> 29 -> 10 -> 7

槽[ 5 ] -> 86 -> 83 -> 64 -> 61 -> 45 -> 42 -> 26 -> 23 -> 4 -> 1

槽[ 6 ] -> 99 -> 96 -> 80 -> 77 -> 58 -> 55 -> 39 -> 36 -> 20 -> 17

槽[ 7 ] -> 93 -> 90 -> 74 -> 71 -> 52 -> 49 -> 33 -> 30 -> 14 -> 11

槽[ 8 ] -> 87 -> 84 -> 68 -> 65 -> 46 -> 43 -> 27 -> 24 -> 8 -> 5

槽[ 9 ] -> 81 -> 78 -> 62 -> 59 -> 40 -> 37 -> 21 -> 18 -> 2

开始删除内容[0,5):

槽[ 0 ] -> 97 -> 94 -> 91 -> 75 -> 72 -> 56 -> 53 -> 34 -> 31 -> 15 -> 12

槽[ 1 ] -> 88 -> 85 -> 69 -> 66 -> 50 -> 47 -> 28 -> 25 -> 9 -> 6

槽[ 2 ] -> 82 -> 79 -> 63 -> 60 -> 44 -> 41 -> 22 -> 19

槽[ 3 ] -> 98 -> 95 -> 76 -> 73 -> 57 -> 54 -> 38 -> 35 -> 16 -> 13

槽[ 4 ] -> 92 -> 89 -> 70 -> 67 -> 51 -> 48 -> 32 -> 29 -> 10 -> 7

槽[ 5 ] -> 86 -> 83 -> 64 -> 61 -> 45 -> 42 -> 26 -> 23

槽[ 6 ] -> 99 -> 96 -> 80 -> 77 -> 58 -> 55 -> 39 -> 36 -> 20 -> 17

槽[ 7 ] -> 93 -> 90 -> 74 -> 71 -> 52 -> 49 -> 33 -> 30 -> 14 -> 11

槽[ 8 ] -> 87 -> 84 -> 68 -> 65 -> 46 -> 43 -> 27 -> 24 -> 8 -> 5

槽[ 9 ] -> 81 -> 78 -> 62 -> 59 -> 40 -> 37 -> 21 -> 18

开始检索结点[0]:未找到

开始检索结点[1]:未找到

开始检索结点[2]:未找到

开始检索结点[3]:未找到

开始检索结点[4]:未找到

开始检索结点[5]:5

开始检索结点[6]:6

开始检索结点[7]:7

开始检索结点[8]:8

开始检索结点[9]:9

=============================================

槽[ 0 ] --> 40 --> 90

槽[ 1 ] --> 11 --> 21

槽[ 2 ] --> 72 --> 62 --> 92

槽[ 3 ] --> 63 --> 93

槽[ 4 ]

槽[ 5 ] --> 35 --> 15

槽[ 6 ] --> 36 --> 26 --> 86

槽[ 7 ] --> 27 --> 77

槽[ 8 ] --> 68

槽[ 9 ] --> 59 --> 49

槽[ 0 ] --> 90

槽[ 1 ]

槽[ 2 ] --> 72 --> 62 --> 92

槽[ 3 ] --> 63 --> 93

槽[ 4 ]

槽[ 5 ]

槽[ 6 ] --> 86

槽[ 7 ] --> 77

槽[ 8 ] --> 68

槽[ 9 ] --> 59

槽[ 0 ] --> 30 --> 90

槽[ 1 ] --> 11

槽[ 2 ] --> 42 --> 22 --> 2 --> 82 --> 72 --> 62 --> 92

槽[ 3 ] --> 73 --> 23 --> 63 --> 93

槽[ 4 ]

槽[ 5 ] --> 35

槽[ 6 ] --> 56 --> 86

槽[ 7 ] --> 67 --> 77

槽[ 8 ] --> 58 --> 68

槽[ 9 ] --> 69 --> 29 --> 59

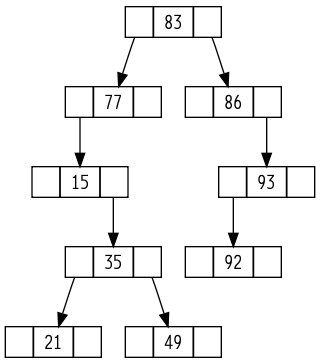

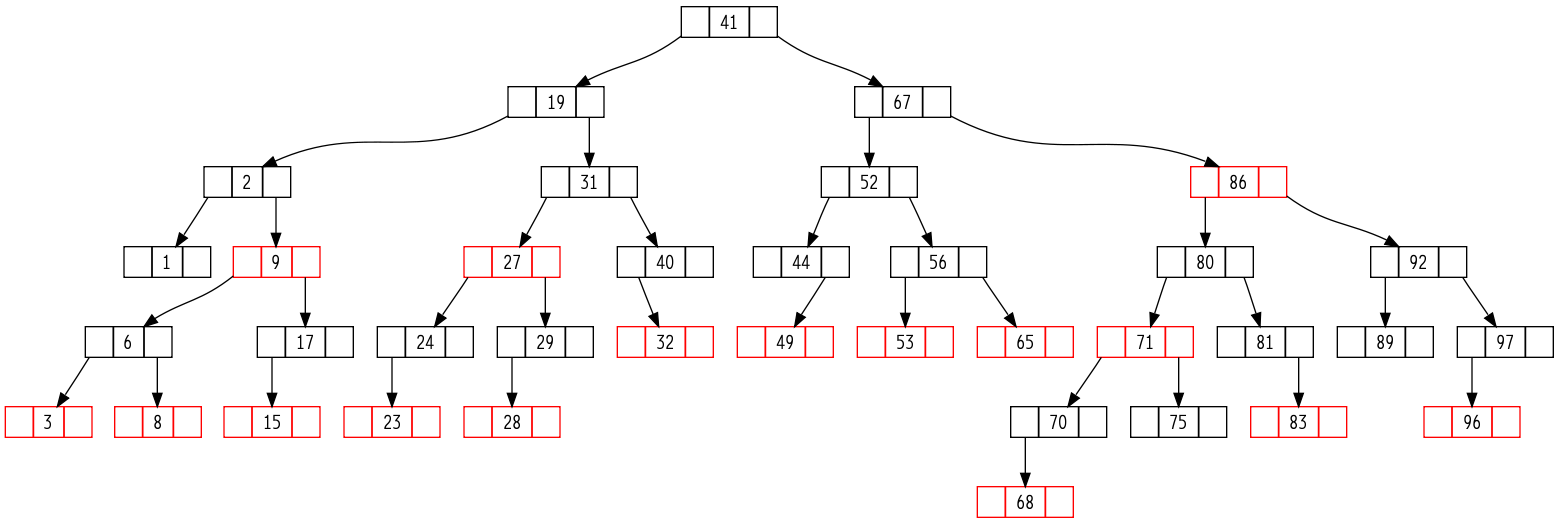

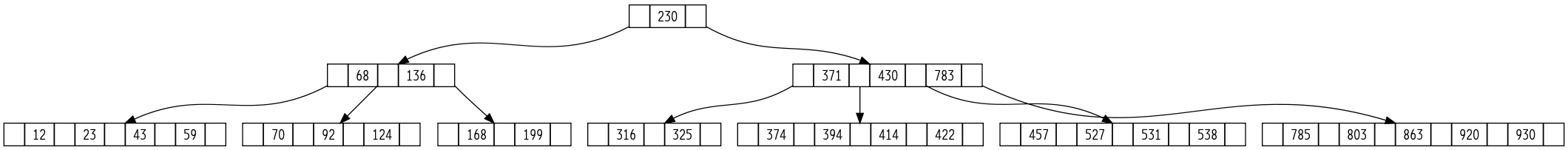

第12章:二叉查找树¶

二叉查找树 的定义:对任何结点X,其左子树中的关键字最大不超过key[X];其右子树中的关键字最小不小于key[x]。

首先先明显:二叉查找树上的基本操作的时间都与树的高度成正比的,所以高度越小的树性能越高。

查询二叉查找树可以考虑使用非递归的版本,它运行要快得多而且也很容易理解:

SEARCH(x, k): while (x != NULL && x.Key != k){ if (k < x.Key) x = x.Left; else x = x.Right; } return x;

- 前趋和后继:

前趋:左一次,然后右到头;后继:右一次,然后左到头。错!不止这么简单,以后继为例:当结点的右子树不存在时,应该一路向上传递,直到找到根结点(没有后继)或者是找到一次非右子树传递(后继找到)为止。我的代码就在这里犯一次错误了,本以为很简单的!以上的这2条只对存在左结点(前趋)或右结点(后继)时才有效。

- 对二叉查找树的插入和删除操作也不复杂,唯一有点难度的地方就是在删除同时存在左右子树的结点时需要进行一些处理。

书上叙述的有点过度的复杂,其实可以很简单地说明白:对于这样的结点x,找到x结点的前趋(或后继)y,将x的值替换为y的值,然后递归删除y结点就可以了。因为y一定没有右子树(后继对应没有左子树),所以递归删除的时候就是很简单的情况了。

可以证明:随机构造的二叉村在平均情况下的行为更接近于最佳情况下的行为,而不是接近最坏情况下的行为。所以一棵在n个关键字上随机构造的二叉查找树的期望高度为O(lgn)。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 | /**

* @file binary_search_tree.cpp

* @brief 二叉查找树

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <algorithm>

#include <vector>

#include <iterator>

#include <iomanip>

#include <limits>

#include <sstream>

#include "graphviz_shower.h"

using namespace std;

namespace ita {

/// @brief 二叉查找树

///

/// 二叉查找树的定义:对任何结点X,其左子树中的关键字最大不超过key[X];其右子树中的关键字最小不小于key[x]。

/// 可以证明:随机构造的二叉村在平均情况下的行为更接近于最佳情况下的行为,而不是接近最坏情况下的行为。所以一棵在n个关键字上随机构造的二叉查找树的期望高度为O(lgn)

class BinarySearchTree {

private:

/// 二叉查找树中的结点

struct _Node {

int Value;

_Node *Parent;

_Node *Left;

_Node *Right;

};

public:

BinarySearchTree() : _root( nullptr ) {}

~BinarySearchTree() {

//从根结点开始递归的析构

_RecursiveReleaseNode( _root );

}

/// @brief 插入一个结点

///

/// 向二叉查找树中插入一个值

/// @param new_value 要插入的值

/// @return 是否插入成功,失败意味着树中已经存在该值

bool Insert( int const new_value ) {

if ( Search( new_value ) ) {

//已经存在

return false;

}

if ( !_root ) {

//插入的是第1个节点

_root = new _Node();

_root->Value = new_value;

return true;

}

//非第1个节点

_Node *current_node = _root;

while ( current_node ) {

_Node *&next_node_pointer = ( new_value > current_node->Value ? current_node->Right : current_node->Left );

if ( next_node_pointer ) {

current_node = next_node_pointer;

} else {

next_node_pointer = new _Node();

next_node_pointer->Value = new_value;

next_node_pointer->Parent = current_node;

break;

}

}

return true;

}

/// @brief 删除结点

///

/// 在二叉查找树中删除一个值

/// @param delete_value 要删除的值

/// @return 是否删除成功,删除失败意味着树中没有这个值的结点

bool Delete( int const delete_value ) {

_Node *delete_node = _Search( _root, delete_value );

if ( !delete_node ) {

//未找到该点

return false;

} else {

_DeleteNode( delete_node );

return true;

}

}

/// @brief 查找元素

///

/// 在当前二叉查找树中查找某一值

/// @param search_value 要查找的值

/// @return 是否在二叉树中找到值为search_value的结点

/// @retval true 查找到了该元素

/// @retval false 找不到该元素

bool Search( int const search_value ) const {

return _Search( _root, search_value ) != nullptr;

}

/// @brief 使用dot描述当前二叉查找树

void Display() const {

stringstream ss;

ss << "digraph graphname" << ( rand() % 1000 ) << "{" << endl

<< " node [shape = record,height = .1];" << endl;

_Display( ss, _root );

ss << "}" << endl;

qi::ShowGraphvizViaDot( ss.str() );

}

private:

/// 真正的删除操作

///

/// 唯一有点难度的地方就是在删除同时存在左右子树的结点时需要进行一些处理。\n

/// 书上叙述的有点过度的复杂,其实可以很简单地说明白:对于这样的结点x,找到x结点的前趋(或后继)y,将x的值替换为

/// y的值,然后递归删除y结点就可以了。因为y一定没有右子树(后继对应没有左子树),所以递归删除的时候就是很简单的

/// 情况了。

/// @note 我这里的方法的确比书上介绍的要好而且容易理解,我这里方法更好的的关键在于:\n

/// 我的_DeleteNode的参数是要删除的结点的指针,所以是在删除同时存在左右子树的结点时,我可以直接使用y

/// 的值赋给x结点,再递归删除y结点。如果本方法的参数不是结点的指针而是结点的值,再递归删除y结点的值

/// 时就会出问题,因为此时x结点的值==y结点的值了。嗯,我的这种以结点指针为参数的思路的确不错!

void _DeleteNode( _Node * delete_node ) {

if ( delete_node->Left && delete_node->Right ) {

//要删除的结点同时存在左子树和右子树

//前驱结点:前驱一定存在,因为该结点同时存在左右子树

_Node *previous_node = _GetPreviousNode( delete_node );

delete_node->Value = previous_node->Value;

//previous_nde一定没有右子树,所以再递归调用一定是走这个if的else分支

_DeleteNode( previous_node );

} else {

//要删除的结点至少有一个子结点为空

//sub_node为delete_node的子树

//sub_node要么为delete_node的左子树,要么为delete_node的右子树,或者在delete_node无子结点时为空

_Node *sub_node = ( delete_node->Left ? delete_node->Left : delete_node->Right );

if ( delete_node->Parent == nullptr ) {

//是第1个结点

_root = sub_node;

} else {

( delete_node->Parent->Left == delete_node

? delete_node->Parent->Left

: delete_node->Parent->Right )

= sub_node;

if ( sub_node ) {

//在delete_node有子结点时需要设置子结点的Parent指针

sub_node->Parent = delete_node->Parent;

}

}

delete delete_node;

}

}

/// @brief 得到一个同时存在左右子树的节点的前驱

///

/// @note node的前驱一定存在,因为node同时存在左子树和右子树,如果不满足这个先决条件,则该算法的结果是错误的。\n

/// 以后继为例:当结点的右子树不存在时,应该一路向上传递,直到找到根结点(没有后继)或者是找到一次非右子树传递(后继找到)为止。我的代码就在这里犯一次错误了,本以为很简单的!

_Node * _GetPreviousNode( _Node * node ) {

if ( !node->Left || !node->Right ) {

//先决条件必须满足,否则求无限制的结点的前驱算法不是这样的

throw std::logic_error( "node必须同时存在左子树和右子树" );

}

//还是注意先决条件:node是一个同时存在左右子树的结点,否则算法不是这样的

//求结点的前驱:先左一下,再右到头

node = node->Left;

while ( node->Right ) {

node = node->Right;

}

return node;

}

void _RecursiveReleaseNode( _Node *node ) {

if ( node ) {

_RecursiveReleaseNode( node->Left );

_RecursiveReleaseNode( node->Right );

delete node;

}

}

/// 非递归查找一个结点

_Node * _Search( _Node *node, int const search_value ) const {

while ( node && node->Value != search_value ) {

if ( search_value < node->Value ) {

node = node->Left;

} else {

node = node->Right;

}

}

//到这里如果node为空就是未找到

return node;

}

void _Display( stringstream &ss, _Node *node ) const {

if ( node ) {

ss << " node" << node->Value << "[label = \"<f0>|<f1>" << node->Value << "|<f2>\"];" << endl;

if ( node->Left ) {

ss << " \"node" << node->Value << "\":f0 -> \"node" << node->Left->Value << "\":f1;" << endl;

_Display( ss, node->Left );

}

if ( node->Right ) {

ss << " \"node" << node->Value << "\":f2 -> \"node" << node->Right->Value << "\":f1;" << endl;

_Display( ss, node->Right );

}

}

}

_Node *_root; ///< 二叉查找树的根结点

};

/// 测试二叉查找树

int testBinarySearchTree() {

BinarySearchTree bst;

//用随机值生成一棵二叉查找树

for ( int i = 0; i < 10; ++i ) {

bst.Insert( rand() % 100 );

}

bst.Display();

//删除所有的奇数值结点

for ( int i = 1; i < 100; i += 2 ) {

if ( bst.Delete( i ) ) {

cout << "### Deleted [" << i << "] ###" << endl;

}

}

bst.Display();

//查找100以内的数,如果在二叉查找树中,则显示

cout << endl;

for ( int i = 0; i < 100; i += 1 ) {

if ( bst.Search( i ) ) {

cout << "搜索[" << i << "]元素:\t成功" << endl;

}

}

return 0;

}

}

int main() {

ita::testBinarySearchTree();

return 0;

}

|

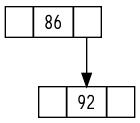

### Deleted [15] ###

### Deleted [21] ###

### Deleted [35] ###

### Deleted [49] ###

### Deleted [77] ###

### Deleted [83] ###

### Deleted [93] ###

搜索[86]元素: 成功

搜索[92]元素: 成功

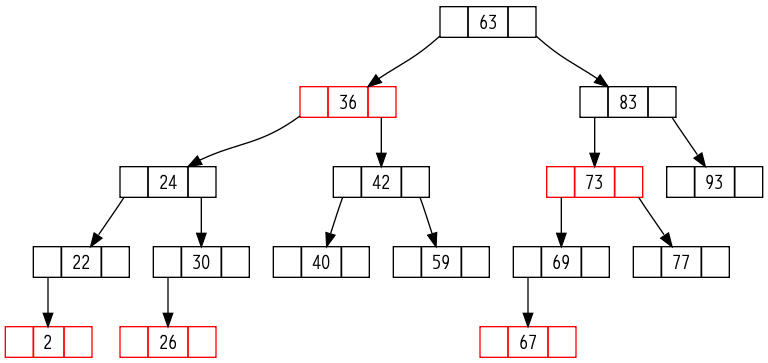

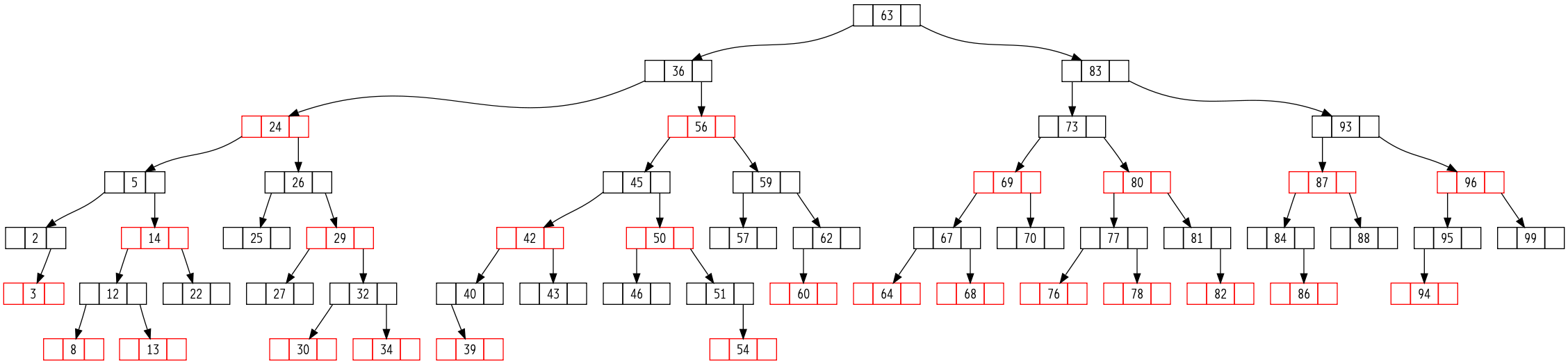

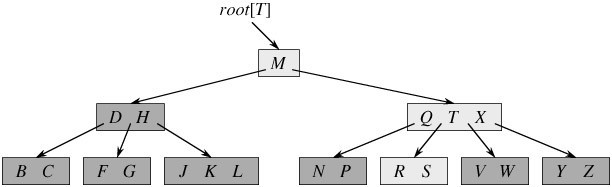

第13章:红黑树¶

满足下面5个条件(红黑性质)的二叉搜索树,称为红黑树:

- 每个结点或是红色,或是是黑色。

- 根结点是黑的。

- 所有的叶结点(NULL)是黑色的。(NULL被视为一个哨兵结点,所有应该指向NULL的指针,都看成指向了NULL结点。)

- 如果一个结点是红色的,则它的两个儿子节点都是黑色的。

- 对每个结点,从该结点到其子孙结点的所有路径上包含相同数目的黑结点(黑高度相同)。

黑高度的定义:从某个结点出发(不包括该结点)到达一个叶结点的任意一条路径上,黑色结点的个数成为该结点x的黑高度。红黑树的黑高度定义为其根结点的黑高度。

红黑树是真正的在实际中得到大量应用的复杂数据结构: C++STL中的关联容器map,set都是红黑树的应用 (所以标准库容器的效率太好了,能用标准库容器尽量使用标准库容器);Linux内核中的用户态地址空间管理也使用了红黑树。

- 红黑树是许多”平衡的”查找树中的一种(首先:红黑树是一种近似平衡的二叉树),它能保证在最坏的情况下,基本的动态集合操作的时间为O(lgn)。

红黑树NB的地方就在于它是 近似平衡,这种近似平衡提高了操作的效率,又不是绝对的平衡,没有带来太多的负作用 。

通过对任何一条从根到叶子的路径上各个结点着色方式的限制,红黑树确保没有一条路径会比其它路径长出两倍,因而是接近平衡的。

全是黑结点的满二叉树也满足红黑树的定义。满二叉树的效率本身就非常高啊,它是效率最好的二叉树了,所以说它是红黑树的一个特例;普通的红黑树要求并没有满二叉树这么严格。

- 旋转操作(左旋和右旋): 旋转操作是一种能保持二叉查找树性质的查找树局部操作 。

所有对红黑树结构的修改都只能通过左右旋来完成,这样才能保证修改后的红黑树首先是一棵二叉查找树。

红黑树的插入操作 :将结点Z插入树T中,就好像T是一棵普通的二叉查找树一样,然后将Z着为红色。为保证红黑性质能继续保持,我们调用一个辅助程序来对结点重新着色并旋转。

这么做是有它的智慧的:首先,插入结点Z的位置的确应该和普通二叉查找树一样,因为红黑树本身就首先是一棵二叉查找树; 然后将Z着为红色,是为了保证性质5的正确性,因为性质5如果被破坏了是最难以恢复的; 到这里,有可能被破坏的性质就只剩下性质2和性质4了,这都可以通过后来的辅助程序进行修复的。

插入操作可能破坏的性质:性质2:当被一棵空树进行插入操作时发生;性质4:当新结点被插入到红色结点之后时发生;红黑树的删除操作 :和插入操作一样,先用BST的删除结点操作,然后调用相应的辅助函数做相应的调整。首先只有被删除的结点为黑结点时才需要进行修补,理由如下:

- 树中各结点的黑高度都没有变化

- 不存在两个相邻的红色结点

- 因为如果被删除的点是红色,就不可能是根,所以根仍然是黑色的

当被删除了黑结点之后,红黑树的性质5被破坏,上面说过了性质5被破坏后的修复难度是最大的。 这里的修复过程使用了一个很新的思想 ,即视为被删除的结点的子结点有额外的一种黑色,当这一重额外的黑色存在之后,性质5就得到了继续。 然后再通过转移的方法逐步把这一重额外的黑色逐渐向上转移直到根或者红色的结点,最后消除这一重额外的黑色。

删除操作中可能被破坏的性质:性质2:当y是根时,且y的一个孩子是红色,若此时这个孩子成为根结点;性质4:当x和p[y]都是红色时;性质5:包含y的路径中,黑高度都减少了;红黑树是平衡查找树,还有B树也是另一类平衡查找树。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323 324 325 326 327 328 329 330 331 332 333 334 335 336 337 338 339 340 341 342 343 344 345 346 347 348 349 350 351 352 353 354 355 356 357 358 359 360 361 362 363 364 365 366 367 368 369 370 371 372 373 374 375 376 377 378 379 380 381 382 383 384 385 386 387 388 389 390 391 392 393 394 395 396 397 398 399 400 401 402 403 404 405 406 407 408 409 410 411 412 413 414 415 416 417 418 419 420 421 422 423 424 425 426 427 428 429 430 431 432 433 434 435 436 437 438 439 440 441 442 443 444 445 446 447 448 449 450 451 452 453 454 455 456 457 458 459 460 461 462 463 464 465 466 467 468 469 470 471 472 473 474 475 476 477 478 479 480 | /**

* @file red_black_tree.cpp

* @brief 红黑树

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <iostream>

#include <algorithm>

#include <vector>

#include <iterator>

#include <iomanip>

#include <limits>

#include <sstream>

#include "graphviz_shower.h"

using namespace std;

namespace ita {

/// @brief 红黑树

///

/// 满足下面几个条件(红黑性质)的二叉搜索树,称为红黑树:

/// -# 每个结点或是红色,或是是黑色。

/// -# 根结点是黑的。

/// -# 所有的叶结点(NULL)是黑色的。(NULL被视为一个哨兵结点,所有应该指向NULL的指针,都看成指向了NULL结点。)

/// -# 如果一个结点是红色的,则它的两个儿子节点都是黑色的。

/// -# 对每个结点,从该结点到其子孙结点的所有路径上包含相同数目的黑结点。

///

/// 红黑树的性质:

/// - 黑高度的定义: 从某个结点出发(不包括该结点)到达一个叶结点的任意一条路径上,黑色结点的个数成为该结点x的黑高度。

/// 红黑树的黑高度定义为其根结点的黑高度。

/// - 红黑树是真正的在实际中得到大量应用的复杂数据结构:C++STL中的关联容器map,set都是红黑树的应用(所以标准库容器的

/// 效率太好了,能用标准库容器尽量使用标准库容器);\n Linux内核中的用户态地址空间管理也使用了红黑树。

/// - 红黑树是许多“<b>平衡的</b>”查找树中的一种(首先:<span style="color:#FF0000 ">红黑树是一种近似平衡的二叉树

/// </span>),它能保证在最坏的情况下,基本的动态集合操作的时间为O(lgn)。

/// - 通过对任何一条从根到叶子的路径上各个结点着色方式的限制,红黑树确保没有一条路径会比其它路径长出两倍,因而是接近平衡的。

/// - 一要全是黑结点的满二叉树也满足红黑树的定义。满二叉树的效率本身就非常高啊,它是效率最好的二叉树了,所以说它是

/// 红黑树的一个特例;普通的红黑树要求并没有满二叉树这么严格。

/// - 红黑树之所以这么高效,是因为它是<span style="color:#FF0000 ">近似平衡</span>的,又不要求完全的平衡,减少了维

/// 护的代价。在计算机科学中有大量的这样的例子,使用近似的东西来提高效率。如二项堆、斐波那契堆等等数不胜数…

/// @param TKey 结点中键的类型

/// @param TValue 结点中值的类型

template<typename TKey, typename TValue>

class RBTree {

public:

/// 红黑树中结点颜色的枚举

enum RBTreeNodeColor {

BLACK, ///< 黑色

RED ///< 红色

};

/// 红黑树中的结点

struct RBTreeNode {

TKey Key; ///< 结点中的KEY

TValue Value; ///< 结点中的值

RBTreeNodeColor Color; ///< 结点的颜色,红色还是黑色

RBTreeNode *Parent; ///< 父结点指针

RBTreeNode *Left; ///< 左孩子指针

RBTreeNode *Right; ///< 右孩子指针

/// @brief 检查是否有效(哨兵结点nil 算作无效结点)

/// @return 该结点是否为有效结点,即不为nil结点

/// @retval true 非nil结点

/// @retval false nil结点

inline bool IsValid() const {

return ( this != s_nil );

}

};

RBTree() {

if ( !s_nil ) {

//叶子结点是一个特殊的黑结点

s_nil = new RBTreeNode();

s_nil->Color = BLACK;

}

_root = s_nil;

}

~RBTree() {

_RecursiveReleaseNode( _root );

}

/// @brief 插入一个结点

///

/// 红黑树的插入操作:将结点Z插入树T中,就好像T是一棵普通的二叉查找树一样,然后将Z着为红色。为保证红黑性质能继续

/// 保持,我们调用一个辅助程序来对结点重新着色并旋转。这么做是有它的智慧的:首先,插入结点Z的位置的确应该和普通

/// 二叉查找树一样,因为红黑树本身就首先是一棵二叉查找树;然后将Z着为红色,是为了保证性质5的正确性,因为性质5如

/// 果被破坏了是最难以恢复的;到这里,有可能被破坏的性质就只剩下性质2和性质4了,这都可以通过后来的辅助程序进行修

/// 复的。\n

/// 插入操作可能破坏的性质:

/// - 性质2:当被一棵空树进行插入操作时发生;

/// - 性质4:当新结点被插入到红色结点之后时发生;

bool Insert( TKey key, TValue value ) {

if ( Search( key )->IsValid() ) {

//key重复,添加失败

return false;

} else {

//新添加的结点为红结点,且Left=Right=s_nil

RBTreeNode *new_node = new RBTreeNode();

new_node->Key = key;

new_node->Value = value;

new_node->Color = RED;

new_node->Left = new_node->Right = s_nil;

_InsertAsNormalBSTree( new_node );

_InsertFixup( new_node );

return true;

}

}

/// @brief 删除一个结点

/// 红黑树的删除操作:和插入操作一样,先用BST的删除结点操作,然后调用相应的辅助函数做相应的调整。\n

/// 首先只有被删除的结点为黑结点时才需要进行修补,理由如下:

/// - 树中各结点的黑高度都没有变化

/// - 不存在两个相邻的红色结点

/// - 因为如果被删除的点是红色,就不可能是根,所以根仍然是黑色的

///

/// 当被删除了黑结点之后,红黑树的性质5被破坏,上面说过了性质5被破坏后的修复难度是最大的。所以这里的修复过程使用

/// 了一个很新的思想,即视为被删除的结点的子结点有额外的一种黑色,当这一重额外的黑色存在之后,性质5就得到了继续

/// 。然后再通过转移的方法逐步把这一重额外的黑色逐渐向上转移直到根或者红色的结点,最后消除这一重额外的黑色。\n

/// 删除操作中可能被破坏的性质:

/// - 性质2:当y是根时,且y的一个孩子是红色,若此时这个孩子成为根结点;

/// - 性质4:当x和p[y]都是红色时;

/// - 性质5:包含y的路径中,黑高度都减少了;

bool Delete( TKey key ) {

RBTreeNode *z = Search( key );

if ( z->IsValid() ) {

//实际要删除的结点,因为后面会有一个交换,所以实际删除y之后就达到了z的效果

RBTreeNode *y = nullptr;

if ( !z->Left->IsValid() || !z->Right->IsValid() ) {

//至少有一个孩子为nil

y = z;

} else {

//左右孩子均不为nil,则找后继

y = _Successor( z );

}

RBTreeNode *x = ( y->Left->IsValid() ? y->Left : y->Right );

x->Parent = y->Parent;

if ( !y->Parent->IsValid() ) {

_root = x;

} else {

if ( y == y->Parent->Left ) {

y->Parent->Left = x;

} else {

y->Parent->Right = x;

}

}

if ( y != z ) {

z->Key = y->Key;

z->Value = y->Value;

}

if ( y->Color == BLACK ) {

_DeleteFixup( x );

}

delete y; //最后实际删除了y结点

return true;

} else {

//要删除的结点不存在

return false;

}

}

/// 在红黑树上搜索一个结点

RBTreeNode * Search( TValue const &value ) {

RBTreeNode *node = _root;

while ( node != s_nil && node->Value != value ) {

node = ( value < node->Value ? node->Left : node->Right );

}

return node;

}

/// 判断红黑树是否为空

bool Empty() {

return !( _root->IsValid() );

}

/// @brief 显示当前二叉查找树的状态

void Display() const {

stringstream ss;

ss << "digraph graphname" << ( rand() % 1000 ) << "{" << endl

<< " node [shape = record,height = .1];" << endl;

_Display( ss, _root );

ss << "}" << endl;

qi::ShowGraphvizViaDot( ss.str() );

}

private:

void _RecursiveReleaseNode( RBTreeNode *node ) {

if ( node->IsValid() ) {

_RecursiveReleaseNode( node->Left );

_RecursiveReleaseNode( node->Right );

delete node;

}

}

void _Display( stringstream &ss, RBTreeNode *node ) const {

if ( node->IsValid() ) {

ss << " node" << node->Value << "[label = \"<f0>|<f1>" << node->Value << "|<f2>\", color = " << ( node->Color == RED ? "red" : "black" ) << "];" << endl;

if ( node->Left->IsValid() ) {

ss << " \"node" << node->Value << "\":f0 -> \"node" << node->Left->Value << "\":f1;" << endl;

_Display( ss, node->Left );

}

if ( node->Right->IsValid() ) {

ss << " \"node" << node->Value << "\":f2 -> \"node" << node->Right->Value << "\":f1;" << endl;

_Display( ss, node->Right );

}

}

}

/// @brief 将一个结点简单地加入红黑树

///

/// 视该红黑树为普通的二叉查找树简单的进行插入操作,需要在此之后调整以满足红黑树的性质

/// @note 一定要保证node->Key一定是一个新的值,否则会无限循环,在这里不检查

void _InsertAsNormalBSTree( RBTreeNode *node ) {

if ( !_root->IsValid() ) {

//插入的是第1个节点

_root = node;

_root->Left = _root->Right = _root->Parent = s_nil;

_root->Color = BLACK;

return;

}

//非第1个节点

RBTreeNode *current_node = _root;

while ( true ) {

RBTreeNode *&next_node_pointer = ( node->Key > current_node->Key ? current_node->Right : current_node->Left );

if ( next_node_pointer->IsValid() ) {

current_node = next_node_pointer;

} else {

//进行真正的插入操作

node->Parent = current_node;

next_node_pointer = node;

break;

}

}

}

/// @brief 对插入操作的修复

///

/// 由于对红黑树的插入操作破坏了红黑树的性质,所以需要对它进行修正

/// @note node的结点是需要处理的结点,由于它破坏了红黑性质,它一定是红结点

void _InsertFixup( RBTreeNode * node ) {

while ( node->Parent->Color == RED ) {

//标识node的父结点是否为node的祖父结点的左孩子

bool parent_is_left_child_flag = ( node->Parent == node->Parent->Parent->Left );

//叔叔结点

RBTreeNode *uncle = parent_is_left_child_flag ? node->Parent->Parent->Right : node->Parent->Parent->Left;

if ( uncle->Color == RED ) {

//case1

node->Parent->Color = BLACK;

uncle->Color = BLACK;

node->Parent->Parent->Color = RED;

node = node->Parent->Parent;

} else {

if ( node == ( parent_is_left_child_flag ? node->Parent->Right : node->Parent->Left ) ) {

//case2

node = node->Parent;

parent_is_left_child_flag ? _LeftRotate( node ) : _RightRotate( node );

}

//case3

node->Parent->Color = BLACK;

node->Parent->Parent->Color = RED;

parent_is_left_child_flag ? _RightRotate( node->Parent->Parent ) : _LeftRotate( node->Parent->Parent );

}

}

//处理性质2被破坏只需要简简单单一句话

_root->Color = BLACK;

}

/// 左旋

///

/// 旋转操作是一种能保持二叉查找树性质的查找树局部操作

void _LeftRotate( RBTreeNode * node ) {

if ( !( node->IsValid() && node->Right->IsValid() ) ) {

//左旋操作要求对非哨兵进行操作,并且要求右孩子也不是哨兵

throw std::logic_error( "左旋操作要求对非哨兵进行操作,并且要求右孩子也不是哨兵" );

} else {

//node的右孩子

RBTreeNode *right_son = node->Right;

node->Right = right_son->Left;

if ( right_son->Left->IsValid() ) {

right_son->Left->Parent = node;

}

right_son->Parent = node->Parent;

if ( !( node->Parent->IsValid() ) ) {

_root = right_son;

} else {

if ( node == node->Parent->Left ) {

node->Parent->Left = right_son;

} else {

node->Parent->Right = right_son;

}

}

right_son->Left = node;

node->Parent = right_son;

}

}

/// 右旋

///

/// 旋转操作是一种能保持二叉查找树性质的查找树局部操作

void _RightRotate( RBTreeNode * node ) {

if ( !( node->IsValid() && node->Left->IsValid() ) ) {

//右旋操作要求对非哨兵进行操作,并且要求左孩子也不是哨兵

throw std::logic_error( "右旋操作要求对非哨兵进行操作,并且要求左孩子也不是哨兵" );

} else {

//node的左孩子

RBTreeNode *left_son = node->Left;

node->Left = left_son->Right;

if ( left_son->Right->IsValid() ) {

left_son->Right->Parent = node;

}

left_son->Parent = node->Parent;

if ( !( node->Parent->IsValid() ) ) {

_root = left_son;

} else {

if ( node == node->Parent->Left ) {

node->Parent->Left = left_son;

} else {

node->Parent->Right = left_son;

}

}

left_son->Right = node;

node->Parent = left_son;

}

}

/// 对删除操作的修复

void _DeleteFixup( RBTreeNode *x ) {

while ( x != _root && x->Color == BLACK ) {

bool node_is_parent_left_child = ( x == x->Parent->Left );

RBTreeNode *w = node_is_parent_left_child ? x->Parent->Right : x->Parent->Left;

if ( w->Color == RED ) {

//case1

w->Color = BLACK;

x->Parent->Color = RED;

_LeftRotate( x->Parent );

w = x->Parent->Right;

}

//case2

if ( w->Left->Color == BLACK && w->Right->Color == BLACK ) {

//两个孩子都为黑结点

w->Color = RED;

x = x->Parent;

} else {

//case3

if ( ( node_is_parent_left_child ? w->Right->Color : w->Left->Color ) == BLACK ) {

( node_is_parent_left_child ? w->Left->Color : w->Right->Color ) = BLACK;

w->Color = RED;

node_is_parent_left_child ? _RightRotate( w ) : _LeftRotate( w );

w = ( node_is_parent_left_child ? x->Parent->Right : x->Parent->Left );

}

//case4

w->Color = x->Parent->Color;

x->Parent->Color = BLACK;

( node_is_parent_left_child ? w->Right->Color : w->Left->Color ) = BLACK;

node_is_parent_left_child ? _LeftRotate( x->Parent ) : _RightRotate( x->Parent );

x = _root;

}

}

//最后只需要简单置x为黑结点就可以,_root的改变已经由左右旋自动处理了

x->Color = BLACK; //改为黑色。

}

/// 得到节点的后继

RBTreeNode * _Successor( RBTreeNode *node ) {

if ( node->Right->IsValid() ) {

//存在右结点时:右一下,左到头

node = node->Right;

while ( node->Left->IsValid() ) {

node = node->Left;

}

return node;

} else {

//不存在右结点时:一直向上,直到找到一次非右孩子或到根了为止

RBTreeNode *y = node->Parent;

while ( !y->IsValid() && node == y->Right ) {

node = y;

y = y->Parent;

}

return y;

}

}

RBTreeNode *_root; ///< 根结点

static RBTreeNode *s_nil; ///< 红黑树的叶子结点(哨兵)

};

template<typename TKey, typename TValue>

typename RBTree<TKey, TValue>::RBTreeNode * RBTree<TKey, TValue>::s_nil = nullptr;

/// 红黑树

int testRedBlackTree() {

int init[] = {11, 2, 14, 1, 7, 15, 5, 8};

RBTree<int, int> bst;

//for ( int i = 0; i < sizeof( init ) / sizeof( init[0] ); ++i )

//{

// bst.Insert( init[i], init[i] );

//}

//bst.Insert( 4, 4 );

//bst.Display();

//用随机值生成一棵二叉查找树

for ( int i = 0; i < 50; ++i ) {

int v = rand() % 100;

bst.Insert( v, v );

}

bst.Display();

//bst.Delete(5);

//删除所有的小奇数

for ( int i = 0; i < 100; ++i ) {

if ( i % 2 == 1 && i < 50 ) {

if ( bst.Delete( i ) ) {

cout << "Deleted [" << i << "]" << endl;

}

}

}

bst.Display();

//删除所有的大偶数

for ( int i = 0; i < 100; ++i ) {

if ( i % 2 == 0 && i > 50 ) {

if ( bst.Delete( i ) ) {

cout << "Deleted [" << i << "]" << endl;

}

}

}

bst.Display();

//再随机添加

for ( int i = 0; i < 50; ++i ) {

int v = rand() % 100;

bst.Insert( v, v );

}

bst.Display();

//删除所有

for ( int i = 0; i < 100; ++i ) {

if ( bst.Delete( i ) ) {

cout << "Deleted [" << i << "]" << endl;

}

}

//bst.Display();

for ( int i = 0; i < 50; ++i ) {

int v = rand() % 100;

bst.Insert( v, v );

}

bst.Display();

return 0;

}

}

int main() {

ita::testRedBlackTree();

return 0;

}

|

Deleted [11]

Deleted [15]

Deleted [19]

Deleted [21]

Deleted [23]

Deleted [27]

Deleted [29]

Deleted [35]

Deleted [37]

Deleted [49]

Deleted [56]

Deleted [58]

Deleted [62]

Deleted [68]

Deleted [70]

Deleted [72]

Deleted [82]

Deleted [84]

Deleted [86]

Deleted [90]

Deleted [92]

Deleted [98]

Deleted [2]

Deleted [3]

Deleted [5]

Deleted [8]

Deleted [12]

Deleted [13]

Deleted [14]

Deleted [22]

Deleted [24]

Deleted [25]

Deleted [26]

Deleted [27]

Deleted [29]

Deleted [30]

Deleted [32]

Deleted [34]

Deleted [36]

Deleted [39]

Deleted [40]

Deleted [42]

Deleted [43]

Deleted [45]

Deleted [46]

Deleted [50]

Deleted [51]

Deleted [54]

Deleted [56]

Deleted [57]

Deleted [59]

Deleted [60]

Deleted [62]

Deleted [63]

Deleted [64]

Deleted [67]

Deleted [68]

Deleted [69]

Deleted [70]

Deleted [73]

Deleted [76]

Deleted [77]

Deleted [78]

Deleted [80]

Deleted [81]

Deleted [82]

Deleted [83]

Deleted [84]

Deleted [86]

Deleted [87]

Deleted [88]

Deleted [93]

Deleted [94]

Deleted [95]

Deleted [96]

Deleted [99]

第14章:数据结构的扩张¶

- 实际的工程中,极少会去创造新的数据结构,通常是对标准的数据结构附加一些信息,并添加一些新的操作以支持应用的要求。

- 数据结构的扩张:指在实际应用数据结构时对标准的数据结构中增加一些信息、编入一些新的操作等等。附加的信息必须能够为该数据结构上的常规操作所更新和维护。

- 对一种数据结构的扩张过程可以分为四个步骤:

- 选择基础的数据结构

- 确定要在基础数据结构中添加哪些信息

- 验证可用基础数据结构上的基本修改操作来维护这些新添加的信息

- 设计新的操作

- 红黑树的扩张定理:当结点中新添加的信息可以由该结点和它的左右子树来决定,那么就可以在不影响时间复杂度的前提下在插入和删除等操作中对红黑树的这些附加信息进行维护。

第四部分:高级设计和分析技术¶

- 设计和分析高效算法的 三种重要技术:动态规划、贪心算法和平摊分析

- 动态规划通常应用于最优化问题,即要做出一组选择以达到一个最优解时。在做选择的同时,经常出现同样形式的子问题。 关键技术是存储这些子问题每一个的解,以备它重复出现。

- 贪心算法通常也是应用于最优化问题,该算法的思想是以局部最优的方式来做每一个选择。采用贪心算法可以比动态规划更快的得出一个最优解,但是关键是不容易判断贪心算法所得到的是否真的是最优解,这是需要证明的,所以说每一个贪心算法后面都有一个漂亮的动态规划算法作为理论支撑。

- 贪心算法可以在一定的理论之下,通过只考虑局部最优解就可以保证得到的一定是全局最优解。如赫夫曼编码。

- 平摊分析是一种用来分析执行一系列类似操作的算法的工具。在一个操作序列中,不可能每一个都以其已知的最坏情况运行,某些操作的代价高些,而其它的低一些。

所有的最优化问题都可以通过穷举法来解决,但是这在时间上是不可接受的。所有的高效算法都是为了加快速度:

- 动态规划:保存子问题的解,以备重复使用

- 贪心算法:用局部最优解来求全局最优解

平摊分析是用来分析算法的工具,它本身并不是一种算法。

第15章:动态规划¶

动态规划与分治法之间的区别:

- 分治法是指将问题分成一些 独立 的子问题,递归的求解各子问题

- 动态规划适用于这些子问题 独立且重叠 的情况,也就是各子问题包含公共子问题

动态规划算法的设计可以分为4个步骤:

- 描述最优解的子结构

- 递归定义最优解的值

- 按自底向上的方法计算最优解的值

- 由计算出的结果反向构造出一个最优解

动态规划最最最重要的就是要找出最优解的子结构 !

最优子结构在问题域中以两种方式变化(在找出这两个问题的解之后,构造出原问题的最优子结构往往就不是难事了):

- 有多少个子问题被用在原问题的一个最优解中

- 在决定一个最优解中使用哪些子问题有多少个选择

动态规划说白了就是一个递归的反向展开的过程:在满足①最优子结构②重叠子问题这2个条件下,通过把递归从下至上的进行展开以避免重复计算子问题从而加速了最终问题的求解的过程。

再次强调”动态规划最关键的一步就是:寻找最优子结构”

动态规划能够消除重复计算子问题是因为它与普通递归相反,它是通过自下而上的方式来进行求解的。

正确使用 动态规划方法的2个关键要素:最优子结构 和 重叠子问题 。

- 如果问题的一个最优解中包含了子问题的最优解,则该问题具有最优子结构;而当一个问题具有最优子结构时,提示我们动态规划可能会适用。

- 如果问题可以由递归来解决,并且在递归的过程中会不断的出现重复的子问题需要解决,那毫不犹豫的采用动态规划吧!

剪贴技术:用来证明在问题的一个最优解中,使用的子问题的解本身也必须是最优的

为了描述子问题空间,可以遵循这样一条有效的经验规则,就是尽量保持这个空间简单,然后在需要时再扩充它

- 非正式地:一个动态规划算法的运行时间依赖于两个因素的乘积:子问题的总个数和每个子问题中有多少种选择。

问题解的代价通常是子问题的代价加上选择本身带来的开销。

贪心算法与动态规划有一个显著的区别:就是在贪心算法中,是以自顶向下的方式使用最优子结构的。贪心算法会先做选择,在当时看起来是最优的选择,然后再求解一个结果子问题,而不是先寻找子问题的最优解,然后再选择。

- 要注意:在不能应用最优子结构的时间,就一定不能假设它能够应用。

坚决警惕使用动态规划去解决缺乏最优子结构的问题!

使用动态规划时: 子问题必须是相互独立的! 可以这样理解,N个子问题域互不相干,属于完全不同的空间。

重叠子问题:不同的子问题的数目是输入规模的一个多项式。这样,动态规划算法才能充分利用重叠的子问题,减少计算量。即通过每个子问题只解一次,把解保存在一个需要时就可以查看的表中,而每次查表只需要常数时间。

从这段描述可以看出: 动态规划与递归时做备忘录的本质是完全相同的,所以说备忘录方法与普通的动态递归本质完全相同,没有孰优孰劣之分,哪个方便用哪个。

由计算出的结果反向构造一个最优解:把动态规划或者是递归过程中作出的每一次选择(记住:保存的是每次作出的选择)都保存下来,在最后就一定可以通过这些保存的选择来反向构造出最优解。

做备忘录的递归方法 :这种方法是动态规划的一个变形,它本质上与动态规划是一样的,但是比动态规划更好理解!

- 使用普通的递归结构,自上而下的解决问题。

- 当在递归算法的执行中每一次遇到一个子问题时,就计算它的解并填入一个表中。以后每次遇到该子问题时,只要查看并返回表中先前填入的值即可。

- 备忘录方法有一个好处就是:它不会去计算那些对最优解无用的子问题,即只计算必须计算的子问题;但是普通的动态规划会计算所有的子问题,不管它是不是必须的。

备忘录方法与动态递归方法的比较:

- 如果所有的子问题都至少要被计算一次,则一个自底向上的动态规划算法通常比一个自顶向下的做备忘录算法好出一个常数因子。因为动态规划没有使用递归的代价,只用到了循环,所以常数因子肯定比递归要好一些。

- 此外,在有些问题中,还可以用动态规划算法中的表存取模式来进一步的减少时间和空间上的需求;

- 或者,如果子问题中的某些子问题根本没有必须求解,做备忘录的方法有着只解那些肯定要求解的子问题的优点。(而且这点是自动获得的,那些不必要计算的子问题在备忘录方法中会被自动的抛弃)

- 备忘录方法总结: 由”是否所有的子问题都至少需要被计算一次”来决定使用动态规划还是备忘录

再次下定义:这两种方法没孰优孰劣之分,因为它们的本质思想是完全一样的;消除重复子问题。

动态规划: 最重要最重要的就是找到最优子结构。在找到最优子结构之后的消除重复子问题,这点我太容易处理了,无论是动态规划的自底向上的递推,还是备忘录,或者是备忘录的变型,都可以轻松的应付。关键就是最优子结构。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 | /**

* @file longest_common_subsequence.cpp

* @brief 最长公共子串问题

*

* Distributed under the GPL License version 3, see: http://www.gnu.org/licenses

* Author: chuanqi.tan(at)gmail.com

*/

#include <vector>

#include <string>

#include <iostream>

#include <algorithm>

#include <iterator>

using namespace std;

namespace ita {

namespace { //匿名命名空间

string const LeftHandSide = "abcbdabbadbcddbacbdad";

string const RightHandSide = "bdcaadcbdbddababba";

/// 普通的递归,时间复杂度为n的指数级

int LongestCommonSubsequenceViaRecurise( int i, int j ) {

if ( i == 0 || j == 0 ) {

return 0;

} else {

if ( LeftHandSide[i - 1] == RightHandSide[j - 1] ) {

return LongestCommonSubsequenceViaRecurise( i - 1, j - 1 ) + 1;

} else {

return max( LongestCommonSubsequenceViaRecurise( i, j - 1 ), LongestCommonSubsequenceViaRecurise( i - 1, j ) );

}

}

}

/// 加入了备忘录功能的递归

///

/// 加入备忘录之后的运行速度超级大幅度的提升,在递归会进行很多重复的子问题的计算的情况下,这样一个小小的改动,极大的提高了效率

/// 两点改动就可以增加备忘录的功能

/// 1:在最前面加一个判断,是否已经计算过了,如果已经计算过了就直接取结果返回.

/// 2:每次要返回之前先把结果保存一下.

int _LongestCommonSubsequenceViaMemoize( int i, int j, vector< vector<int> > &memoize, vector< vector<int> > &chooses ) {

//这个检查备忘录的过程就是“备忘录”方法与普通递归的区别

//所以说备忘录方法简单好用,只需要使用递归的思维,再加上一个备忘子递归结果的memoize就可以了。

if ( memoize[i][j] != -1 ) {

//先检查已经存在于备忘录中

return memoize[i][j];

}

if ( i == 0 || j == 0 ) {

memoize[i][j] = 0;

return 0;

} else {

if ( LeftHandSide[i - 1] == RightHandSide[j - 1] ) {

//写备忘录

memoize[i][j] = _LongestCommonSubsequenceViaMemoize( i - 1, j - 1, memoize, chooses ) + 1;

chooses[i][j] = 0; //记录选择for step 4

} else {

int i_sub = _LongestCommonSubsequenceViaMemoize( i - 1, j, memoize, chooses );

int j_sub = _LongestCommonSubsequenceViaMemoize( i, j - 1, memoize, chooses );